-

Liczba zawartości

761 -

Rejestracja

-

Ostatnia wizyta

Typ zawartości

Profile

Blogi

Forum

Kalendarz

Posty dodane przez Adames

-

-

AMD robi produkty tańsze i o niższej funkcjonalności, są to jednak pełnoprawne produkty. Jednym to odpowiada, innym nie. Jak dla mnie to nawet karty intela mają większą użyteczność, tylko ja nie tylko gram, gry to ledwie dodatek.

Pamiętam reklamę Dacii z kosiarką, tak to AMD reklamuje raytracing i AI w nvidii

Tylko akurat ja potrzebuję tej kosiarki xD

-

Jedna z tańszych:

ASUS Z790 Pro Art:

Ważne:

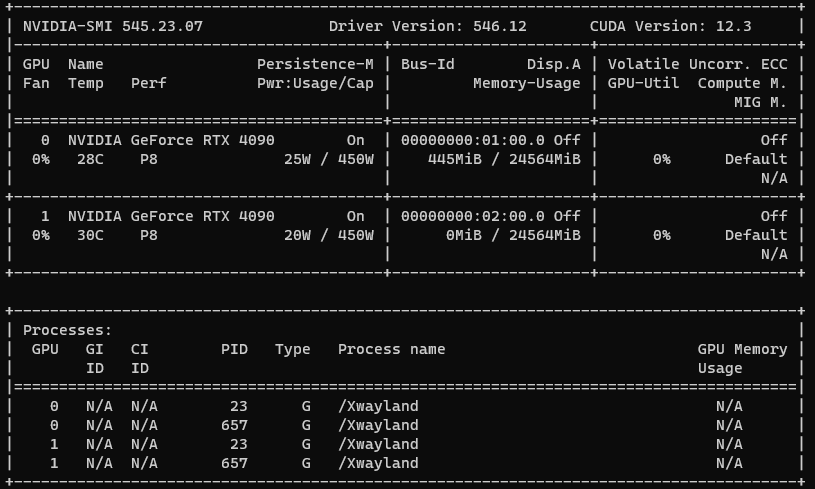

Ja przy dwóch GPU i 3 dyskach nvme musiałem wyłączyć opcje "oszczędzania energii" dla PCIE, inaczej robiło to problemy z stabilnością. Przy jednej karcie takich problemów nie było. -

4 godziny temu, wid3l3c napisał:

Mamy proce na "w przód na kilka lat", za czym tu więc gonić?

Do czego Ci więcej rdzeni potrzeba? skoro te są wykorzystywane w jakichś absurdalnych 20-30%.

skoro te są wykorzystywane w jakichś absurdalnych 20-30%.

Jak popatrzysz się na ogólną historię rozwoju IT, to zwykle najpierw pojawia się nowy sprzęt z "niepotrzebną" wydajnością, a potem pojawia się mnóstwo zastosowań dla tej wydajności. Najpierw Nvidia wprowadziła GeForce 8800 GT z CUDA, a potem świat naukowy przerzucił się na nowy sposób prowadzenia obliczeń, dzięki temu mamy ChatGPT.

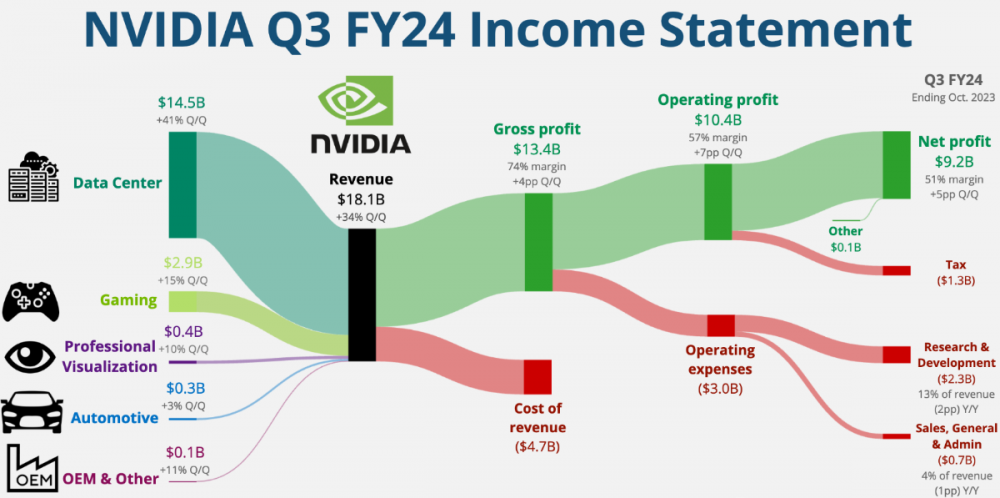

Tak poza tym, to jak już wspomniano, wydajniejszy procek = lepszy komfort pracy, szybciej wykonane zadania, za to się płaci. Jak popatrzysz na strukturę przychodów NVidii, to "gejming" stanowi niewielki kawałek tortu:

Intel niestety nie prowadzi podziału na produkty "gamingowe" i "robocze". Podejrzewam, że procki do pracy też stanowią u nich większość przychodu.

-

Taki MSI Suprim Liquid X jest całkiem dostępny w niezmienionej cenie 9500 zł

A tu w "promocji" wersja bez X:

https://www.x-kom.pl/p/1075541-karta-graficzna-nvidia-msi-geforce-rtx-4090-suprim-liquid-x-24gb-gddr6x.htmlDla lubiących "low end" - Ventus za 8599 zł

Faktem jest jednak to, że ciężko znaleźć kartę poniżej 8 tyś zł, gdzie kilka miesięcy temu było ich całkiem sporo do wyboru.

-

2 godziny temu, Rebelmind napisał:

Zasadnicza odpowiedź: w_Uj..., możesz być pewien.

Nie koniecznie musi to być prawda w całej linii GPU. Trochę to zależy od tego, jakie segmenty kart wyznaczy NVidia i jak długo będą chcieli trzymać "last gen" przy życiu. Popatrz na 3060Ti vs 4060Ti, cena praktycznie identyczna, wydajność też xD Jedyny "realny" powód do kupienia tego to DLSS FG. Segmenty low-end i entry-level są całkowicie pominięte w tej generacji. Istnieje szansa, że RTX 5000 będą tak okrojone, by być niewielkim upgrade w stosunku do 4000, a jedyne co tak naprawdę będzie w ofercie to "nowe ficzery" a "prawdziwe" karty wtedy trafią do farm obliczeniowych i usług grania w chmurze.

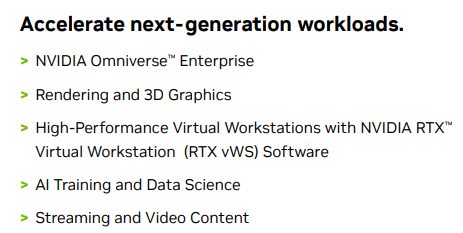

Taki Nvidia L40 48GB jak najbardziej wspiera gaming

-

Natchniony przez Zbuntowany Umysł ( @Rebelmind ) rozpoczynam dyskusję i hype dla nowej generacji naszych ukochanych GeFroce - RTX Blackwell.

Powoli zaczynają się wzmianki dot. tego co możemy się spodziewać:

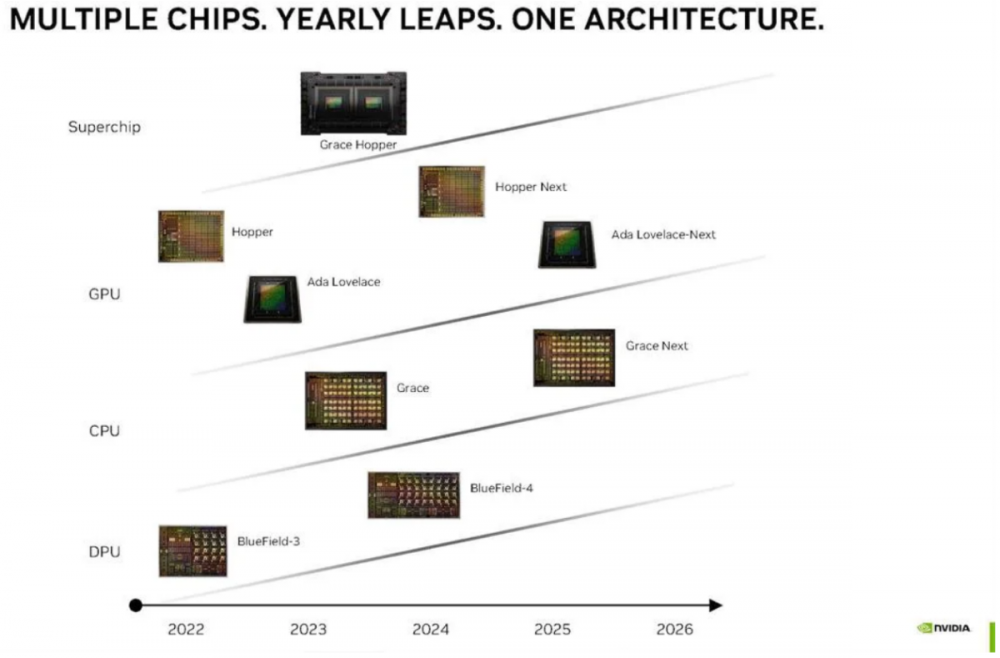

Sama NVidia też już jakiś czas temu zaprezentowała uaktualnioną ścieżkę rozwoju swoich produktów:

Obecna generacja (RTX 4000) niedawno przeszła refresh - wydano RTX 4000 Super, wielkim nieobecnym tej generacji jest natomiast karta RTX 4090Ti, która w większym stopniu wykorzystywałaby pełen rdzeń AD102. Karty z pełnym rdzeniem są sprzedawane na potrzeby datacenter - np: Nvidia L40, czy na potrzeby innych akceleratorów do AI.

Wróżąc z fusów spodziewałbym się w nowych kartach:

- Większej różnicy pomiędzy kartami dla segmentu datacenter i konsumenckiego

- Jeszcze wyższych cen wszystkich modeli - kampania marketingowa usługi GeForce NOW!

- Zdecydowanie wyższej wydajności w AI, niekoniecznie w samej rasteryzacji.

- Modele niższe od topowych - okrojoną szynę pamięci - sporo badań skupia się na temacie kompresji, w tym także wykorzystanie generatywnych AI do tego celu. Wprowadzenie rozszerzenia sprzętowego dedykowanego kompresji z wykorzystaniem AI wydaje się prawdopodobne. Podobnie jak w obecnej generacji część problemów wywołanych przez wąską szynę pamięci jest kompensowane przez większy CACHE, a "udoskonalone" rozszerzenia NVOFA (Nvidia Optical Flow Accelerator) wspierają wykorzystywanie DLSS FG.

-

Nvidia coś znów pokićkała z nazwami, poprawna nazwa kolejnej generacji GPU to RTX Paywall, który w dniu premiery skutecznie odetnie tych bez portfela do grania w chmurze lub na konsolach od Gamingowej Elity, która zapłaci każde pieniądze za nawet najbardziej syfiasty kawałek nowego hardware. Pierwsze zdjęcia nowego gpu już wyciekły dawno temu:

-

Co wy macie z tym poborem mocy na radeonach?

Przy wyświetlaniu pulpitu:

-

Co do opłacalnego chłodzenia, to jak dla mnie wybór jest jeden:

https://proline.pl/chlodzenie-wodne-arctic-liquid-freezer-ii-420-acfre00092a-p7113788Jak mu się doda drugi rząd wentylatorów i ramkę, to ogarnie nawet 13900K bez kagańca

Ofc obudowa, która pomieści takie bydle to musi być spora, ale nie koniecznie bardzo droga. Corsair 7000D airflow jest w sam raz.

Co do gpu, to jak już płaci się ponad 9 tyś za kartę, to warto dopłacić jeszcze te dwie stówki do:

Mam dwa takie i jestem mega zadowolony. Karta cicha, chłodna i nawet ładna.

-

-

Nie pomyślałem o tym w sumie. Miałem kiedyś monitor z wbudowaną kartą sieciową.

Szkoda, że nie napisali nawet jaka to karta sieciowa.

Czy tylko ja mam wrażenie, że ostatnio oficjalne manuale stały się jakieś ubogie? Tragedia po prostu.

-

Cześć,

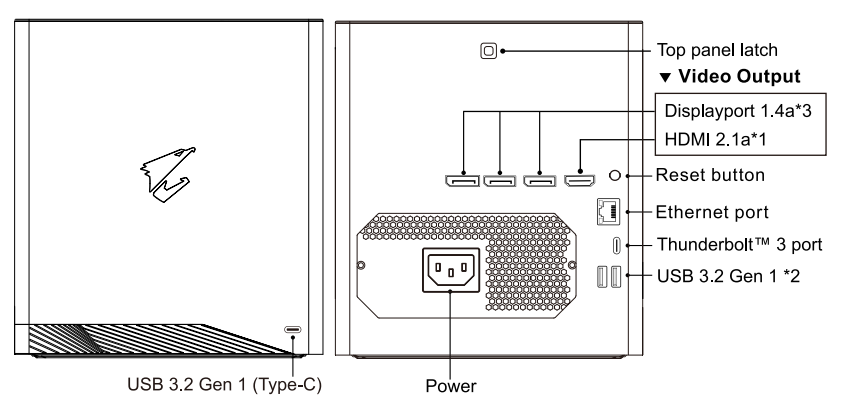

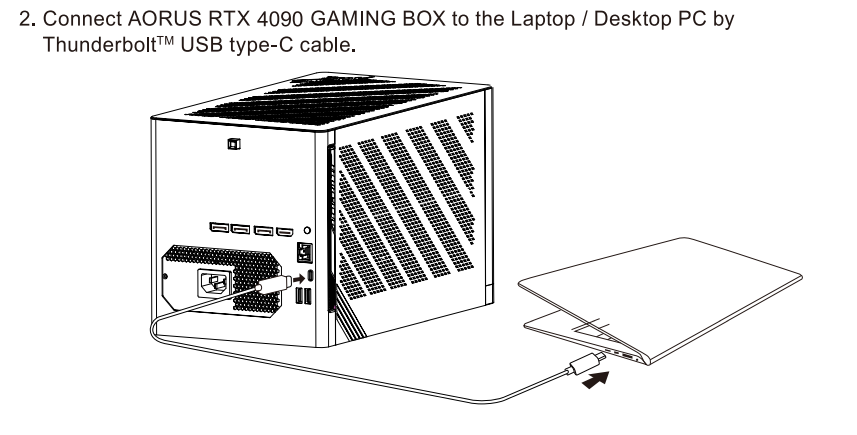

Wie ktoś do czego jest i jak można wykorzystać port ethernet umieszczony na zewnętrznej karcie Gigabyte Aorus RTX 4090 Gaming Box 24GB GDDR6X? Chodzi dokładnie o ten sprzęt: https://www.gigabyte.com/Graphics-Card/GV-N4090IXEB-24GD#kf

Serio pytam, zastanawiam się nad kupieniem takiej karty, bo wydaje się to fajny sprzęcik do uczenia i nie mogę jakoś znaleźć info, po co ten port ethernet tam jest.

Tak, zaglądałem do manuala - jest tam tylko stwierdzone, że taki port karta posiada i potem wepnij usb-c ... .

Fajnie jakbym mógł sobie podglądać obciążenie GPU po sieci bez dodatkowych usług na komputerku, który aktualnie uczy xD

Może ktoś już używał takiego wynalazku?

-

Odpowiem trochę przewrotnie - ma to mniejsze znaczenie niż myślisz

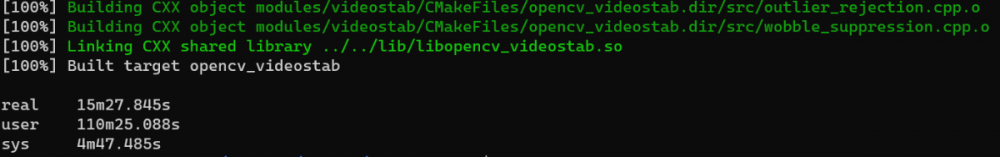

Ogólnie to kompilacja kodu to jest właśnie to zadanie, które potrafi w pełni wykorzystać wszystkie rdzenie. Tutaj teoretycznie te 20 rdzeni w i7 14700k robi "sporą" różnicę względem 12 jakie są w Ryzen 9 Pro 7945, nawet jeżeli "prawdziwych" rdzeni jest tylko 8. Testy syntetyczne (np kompilacja chromium) niespecjalnie wiele mówią o "odczuwalnej" różnicy w prockach przy programowaniu. Visual studio umie używać cache, więc przy każdym kolejnym budowaniu projektu nie odczujesz różnicy pomiędzy prockiem nawet 2x szybszym w praktyce nie istnieje. Pythonowi jako z natury powolnemu językowi to nie robi różnicy -.-" Dobrze zrobione wirtualki wcale za wiele zasobów nie potrzebują.

4 godziny temu, mariuszg82 napisał:Wiem, że teraz LGA1700 to ślepa uliczka

To zależy jak długo masz zamiar używać maszynę w niezmienionej formie. Jeżeli rok - dwa a potem upgrade, wtedy faktycznie to może mieć znaczenie. Jeżeli jednak postawisz maszynę na następne 5+ lat to nie ma to większego znaczenia. Za 5 lat zapewne AM5 też już będzie przestarzałe (AMD obecnie zapowiada wsparcie do 2025 roku).

-

@sid vicious Czy to przez ten wściekły znak zapytania całe forum wyeskportowało w kosmos na kilka dni?

-

3

3

-

-

Liczę, że zrobią jakąś TOP edycję z 32 GB lub 48 GB, mogli by mieć większe cyferki niż "biedne karty po 24 GB" a i użytek z nich też by się zrobiło. Taki RTX 4090 w wersji 48GB by dosłownie miażdżył ... sam siebie w wersji 24 GB. Jedyne co jest obecnie potrzebne konsumenckim kartom, to WINCYJ VRAM!

-

Od siebie tylko dodam, że ogólna różnica pomiędzy RTX 4070 z dopiskiem "Ti" a bez, jest całkiem spora, podobnie jak różnica w cenie, nie jestem pewien jednak czy ta karta jest jakkolwiek opłacalna. Wolałbym pogodzić się z niższą wydajnością i kupić 4070 zwykłego za ~2800 zł albo jednak dusić portfel na RTX 4080 za ~5,2 tyś.

-

1

1

-

-

Cześć,

Nie jestem pewien, czy to czego oczekujesz da się spełnić w zakładanym budżecie. Niestety, jak oczekujesz oczekując więcej niż 30 FPS w 4K z RT na maxxx, to w nowych grach taki RTX 4090 to potrafi bez wspomagaczy lub 60 FPS z wspomagaczami.

Granie przy 60 FPS z włączonym DLSS FG (czyli realnie 30 bez FG) jak dla mnie to tragedia w dynamicznych grach. Opóźnienia są tak ogromne, że dynamiczna gra staje się momentalnie niegrywalna.

Link do "nie randomowego" testu:

Piszę o tym, bo warto przy takim budżecie na gamingowego PC zrewidować swoje oczekiwania co do "jakości" oferowanej rozgrywki. Ofc, nie każda gra jest tak wymagająca jak Cybrpunk, aczkolwiek tych wymagających jest co raz więcej.

-

1

1

-

-

-

To jest bardzo zły pomysł:

- dwie karty średniego segmentu

- różnych producentów

- płyta nieprzystosowana do multi-gpu (brakuje 2 slotu x8, by mogły pracować w trybue x8/x8)

Taka konfiguracja = problemy!

Najlepiej:

Kupić jedną mocną kartę a do wyświetlania pulpitu użyć iGPU.

-

Od strony tego co robię, to czekam na 5090, bo zwykle to nie tylko nowe dżiforsy do szybszego liczenia AI ale także nowe Jetsony (ostatni bazuje na Ampere). Na nowe karty Intela też czekam, pewnie będę miał jakiś średni model 2-3 miesiące po premierze.

Prywatnie - czekam na Nintendo Switch 2 -.-" Kupując zwykłego switcha nie spodziewałem się nawet jak fajne może być Mario i Ring Fit. Bawiłem się też chwilę Steam Deckiem, ehh gdyby nie był taki ciężki, te dodatkowe 1/4 kg robi różnicę jak to się trzyma w ręku. Przecieki mówią, że nowy switch będzie oparty o Ampere. Czyli jak zwykle - "technicznie" to wyjdzie dwie generacje wstecz.

-

1 godzinę temu, droid napisał:

W co iść rtx 4070 czy rx 7800 xt dla GTA 6?

Żadne z nich - pod tą grę potrzebny będzie RTX 5090 by odpalić w 1080p z rat tracingiem i dlss FG2.

-

2

2

-

-

Niestety tu będą schody, ta karta lubi pcie gen 4 + rebar, bez tego to kiepsko.

Lista oficjalnie wspieranych konfiguracji sprzętowych:

https://www.intel.com/content/www/us/en/support/articles/000091128/graphics.html

Wszystko poza tym to już niezbadane wody. Sam odpaliłem ARC A750 na Asrock X399 PG + Threadripper 1920X. Dało się, miałem jednak to szczęście, że była aktualizacja bios, która zapewniała rebar, bez tego była tragedia wydajnościowa.

-

Najlepiej by było ulepszyć CPU i GPU, jedno i drugie już obecnie się trochę zestarzało. Nie polecam jednak pchać się w R5 3600, to droga donikąd, zdecydowanie lepszym pomysłem jest Ryzen 5 5500, który na x-komie kosztuje 30 zł więcej. Jeżeli masz jednak zamiar grać w rozdzielczości 4K, to przy takim "średnim" gpu, to procek nie jes aż tak wielkim problemem, więc można najpierw kupić mocniejszą kartę graficzną.

Radeon 7600 to też nie jest raczej karta pod gry w rozdzielczości 4K, nie pod nowe gry przynajmniej. Bierzesz używki pod rozwagę? W okolicy 1200 zł można kupić takiego RX 6700XT, który jednak pozwoli na trochę więcej. Troszkę drożej to jeszcze jest taki RX 6800, który zdecydowanie lepiej się nada do grania w 4K.

-

Ale po co? Mam takie wrażenie, że rynek na jakiś czas się nasycił. Ci co mieli ciśnienie pewnie już dawno kupili a pozostali nie śpieszą się. Na jakieś znaczące ruchy cenowe to szykowałbym się na czerwiec - wrzesień w 2025 roku, wtedy prawdopodobnie Nvidia jak i AMD naszykują "ostateczne" czyszczenie magazynów. Tak jakoś by ludzie wykupili resztki RTX 40xx i RX 7xxx przed premierą Next-Next gen

. Może zielonym zmienią się plany i zrobią premierę w 2024, wtedy może już w czerwcu pojawią się "promocje".

. Może zielonym zmienią się plany i zrobią premierę w 2024, wtedy może już w czerwcu pojawią się "promocje".

Te refresze są prawdopodobnie skutkiem ubocznym, który jest przekuwany w lekki marketing. Nie spodziewam się by jednak nagle powstało realne parcie na nowe produkty.

Temat o kartach graficznych INTEL, aka trzeci gracz

w Karty graficzne

Napisano

Panowie, Panowie, aż dziś wsadzę ARCa do mojego prywatnego komputerka Trafi tam zamiast RTX 3060Ti, posiedzi najbliższy miesiąc.

Trafi tam zamiast RTX 3060Ti, posiedzi najbliższy miesiąc.

Nawet jakby był 50% wydajniejszy w AI to w dalszym ciągu to za mało by realnie konkurować z NVidią czy Intelem. Jeżeli mówimy o pracach związanych z AI i wykorzystaniem konkretnego środowiska w realnych projektach, to zaplecze składające się z jednego modelu karty konsumenckiej i jednej profesjonalnej to trochę mało by jakkolwiek rozpatrywać wykorzystanie karty.

AI nie uczy się tylko po to by było fanie nauczone, tylko do tego by wykorzystać potem do rozwiązania rzeczywistego problemu. Z mojej praktyki wynika, że użycie potem zwykłej stacjonarki, na której sieć projektowano / uczono, zwykle nie wchodzi w grę. Ograniczenia związane z ROCm są takie, że ciężko jest nawet znaleźć laptopa, na którym wykorzystam taką sieć zaprojektowaną / uczoną na czymś innym.