-

Liczba zawartości

2048 -

Rejestracja

-

Ostatnia wizyta

Typ zawartości

Profile

Blogi

Forum

Kalendarz

Posty dodane przez Revenant

-

-

Co do ch...wasta...

Coś mi jednak nie pasiło na SmartTV (sprawdziłem jeszcze raz, ale tak mega się przyglądałem detalom - upiększacze SmartTV mogły cos maskować) więc zacząłem testowac tam na YT Demo 4K i takie "hmmm coś jakość się nie zgadza" (wybrałem film z lepszą ilością detali, drzew itp).

Wypiąłem monitor z listy zasilania, listwa on-off i podłączyłem ponownie.

Jest dobrze. 2h czasu zmarnowałem, nawet GPU wyjmowałem i wsadzałem z PCI-e i spr slot...A ostatnio odpiąłem PC od listwy bo powodowała random restarty (markowa listwa x2 topikowa za ponad stówę, ma ze 2-3 lata...). Ale żeby monitor źle wyświetlał parametry? Ja już nic nie rozumiem, za stary się robie. Jeszcze trochę i skończę z macbookiem jak totalna geriatria.

-

-

Mam problem... włączałem dziś PC i mam jakby rozmazany/blurred/low-res ekran... Robiłem reinstall driverów z DDU i nic (back do 23.12) i nadal to samo. Rozdzielczość w windowsie jest ustawiona odpowiednio wraz z refresh rate oraz głębia kolorów... kabel HDMI sprawdziłem... jakies pomysły?

Cały obraz wydaje się jakby był w niższej rozdzielczości albo jakiś upscalowanyy... ciężko to wyjaśnić. Jest dramat, ledwo mogę tekst przeczytać. -

Patrząc temp hotspot na TPM możesz go olać. Świetna temperatura (bdb cooler), nie ma sensu grzebać do momentu pump-out (obstawiam od 2 do 6mc od nałożenia kryonauta w zależności od godzin pracy w max temp. i wielu cyklach chłodzenia).

Korekta, byłeś blisko: Jak przesadzisz z taktami VRAM to spada ale nie powerlimit a Core Frequency, jest jakaś dziwna korelacja w BIOS - prawdopodobnie jakiś overcurrent protection dla jakiegoś elementu na PCB (moja teoria).

PTM brałem z allegro od topowego sprzedawcy, po temperaturach wnioskuję że oryginał. Łatwiej w razie czego zgłosić RMA i wystąpić o zwrot hajsu niż na ali.Btw, nie polecam mieć zainstalowanego Afterburnera przy kartach RDNA2/RDNA3 i potwierdza z autopsji. Powoduje to wiele problemów na poziomie sterownika. Z resztą (sam korzystałem z tej apki dłużej niż dekadę) nie posiada żadnej przewagi nad sterownikiem AMD.

-

Jak coś takiego z obsługą CUDA to po taniości może warto rozejrzeć się za RTX 3060 12GB.

RAM 2x16GB 32GB 3600MHz powinien styknąć, lub dorwać dwie kolejne takie same kości jakie masz (zakładając, że: CPU uciągnie x4 DIMM przy 3600MHz oraz te kości mogą pracować w trybie x4, ale to ostatnie dotyczy głównie modułów 32GB). -

MSI znów się zbłaźniło, uwaga jak ktoś planuje zakup i nie czuje się komfortowo flashując vbios.

https://videocardz.com/newz/msi-apologizes-for-rtx-4070-ti-super-bios-issues

-

1

1

-

-

AFMF tak jak każdy inny framegen należy olać i zakopać. I przy DLSS i przy FSR3 włącznie. Niech się skupią na jakości produktów a nie ficzerach przydatnych tylko podczas prezentacji tabelek prasie.

Większy ficzer to skalowanie rozdziałki na YT itp.

11 godzin temu, mlekolak napisał:

11 godzin temu, mlekolak napisał:Jasne, porównuję po prostu

Mówię o TBP, czyli cała karta. Mam Asrocka Phantom, tutaj +15 2950/1140 to jest coś koło 450W średnio w BF2142 i bez problemu dobija do 500W, ale słychać że karta już dostaje mocno po du**e

Mówię o TBP, czyli cała karta. Mam Asrocka Phantom, tutaj +15 2950/1140 to jest coś koło 450W średnio w BF2142 i bez problemu dobija do 500W, ale słychać że karta już dostaje mocno po du**e  Na 2800 średnio wychodzi dokładnie 410W i temperatury są znośne.

Na 2800 średnio wychodzi dokładnie 410W i temperatury są znośne.

Mówisz że ten PTM7950 daje radę, hmm u mnie na Thermal Grizzly Kryonaut Extreme i bloku wodnym hotspot przy 2800MHz/1018mV dobija do 70-73*C. Przed założeniem bloku na def było pod 90*C.

PTM7950 okazuje się być dziwnym cudem do ratowania temperatur hotspot przy RDNA3. Idk czemu. I eliminuje największy problem - pumpout pasty. Kryonaut to najgorsza pasta pod tym względem, zawsze mnie irytował błyskawiczny pump-out na niej. A jeżeli SYY-157 (klon TGX) mi wypompowało po 3mc... to kryonaut szybko umrze (1-2mc max i zaczną się spadki temp i wzrosty hotspot na niektórych fragmentach core). Temperatury CORE raczej będą takie same względem każdej topowej pasty. Ale hotspot pokazuje szybko brutalną rzeczywistość, która kryje się w szczegółach (w tym stabilność, lifespan, fan_speed).

BF2042 jest słabą grą do testów RDNA3 (wiem bo mam i gram). Zegary tam są bardzo wysokie, szczególnie w moim przypadku przy 4K. Gra jest bardzo delikatna i nawet duże uV, które jest często niestabilne tam da radę. Najbardziej brutalny imo jest Elden Ring z RayTracingiem, najszybiej powoduje niestabilność sterownika przy zbyt niskim napięciu lub błędach VRAM. Cyberpunk jest zaraz za nim przy stabilności Core i na równo z VRAM. Ale do testów uwielbiam też TW:WH3, który gdy zajmie 18-21GB VRAM i generuje chore ilości ciepła na GPU jest świetnym testem stabilności.

Tą kartę masz? https://www.techpowerup.com/gpu-specs/asrock-rx-7900-xtx-phantom-oc.b9957

Przy +15% PL max powerlimit TBP wynosiłby 408-415W tak jak mój Pulse (zależnie od tego jak liczą procenty na watty) -

2 godziny temu, mlekolak napisał:

OK, 2800 to jest Twój max OC? Mój RX dobija do 500W TBP Power Limit +15, 1150mV, 2400-2950 i pamięci na Def timingach 2714Mhz. Ale wychodzi podobnie do Ciebie, najrozsądniej 2400-2800 1080mV.

Pulse ma powerlimit +15% na 415W.

Co do napięcia to mowię tutaj o ekstremalnej stabilności, gwarantowanej wszędzie i zawsze. W niektórych grach i 1040-1050mV jest stabilne w 100%. Ale Cyberpunk i Elden Ring bardzo ostro weryfikują stabilność. I weź pod uwagę że ja gram w 3840x2160, czyli najbardziej taxującej rozdzielczości, przy 1440p można byłoby zejść niżej jeszcze z napięciem (plus tym wyższa rozdziałka tym GPU zawsze boostuje niżej).

500W to raczej poziom jakiegoś Nitro+ albo Devila, zwykły AIB nie będzie miał takiego biosu. I kwestia czy mówisz o odczytach z TBP czy "GPU Power Maximum", bo tutaj to i faktycznie potrafi być nanosekundowy spike do 450-500W czasami (dosłownie na 1ms albo mniej, ale były). Takie spike'i najczęściej chyba widziałem w Metro Exodus ale to było jakoś w wakacje, teraz dokładnie już nie pamiętam. -

7 godzin temu, mlekolak napisał:

Tutaj mówisz o TGP czy TBP?

TBP -

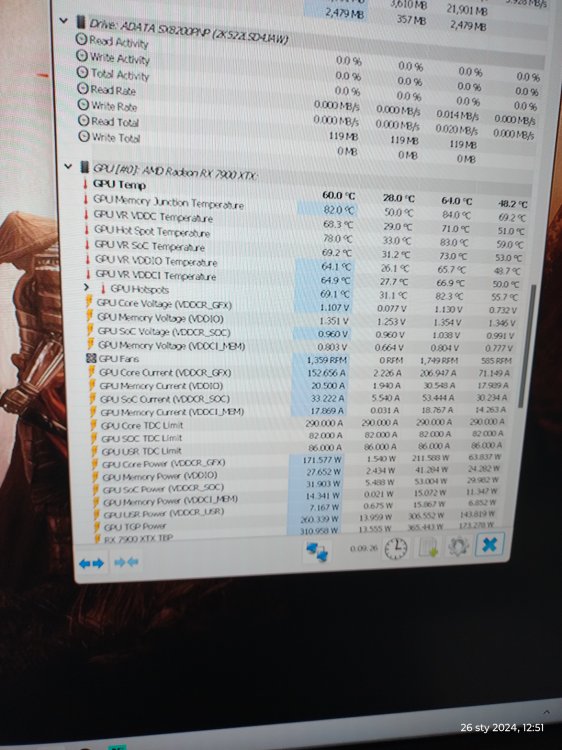

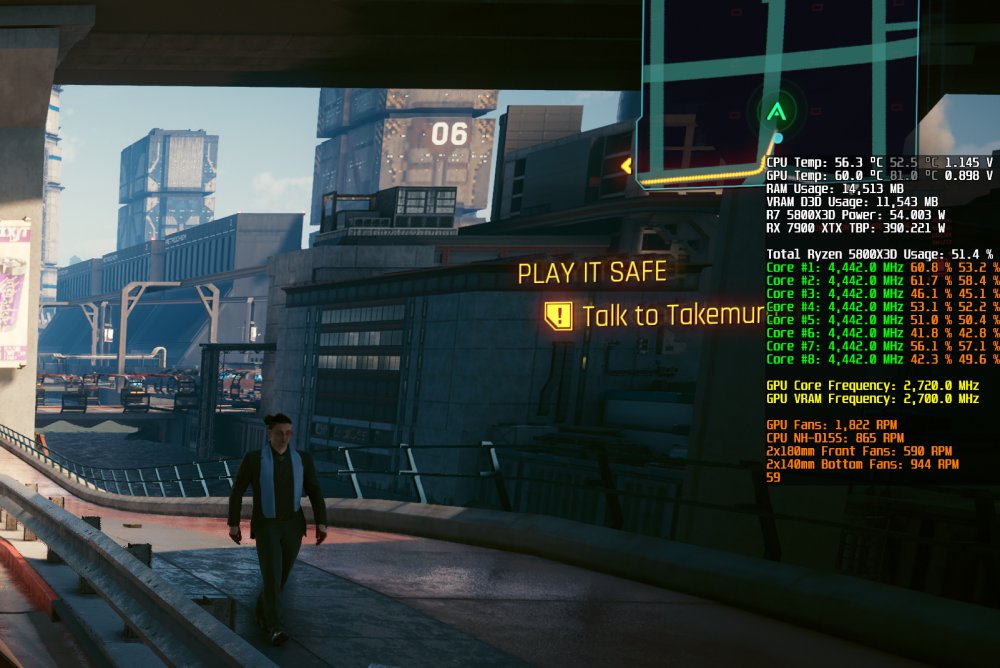

7900 XTX ma już jeden roczek na karku. Więc na nowych driverach (24.1.1) sprawdziłem skalowanie perf per watt.

Odczyty ze średnich po 8 minutach per clock freq (wahania były bliskie zeru, więc dobra lokalizacja do testów).

2400MHz Core = 71fps = 309w (1fps = 4,35W)

2500MHz Core = 73fps = 333w (1fps = 4,56W)

2600MHz Core = 75fps = 380W (1fps = 5,06W)

2700MHz Core = 77fps = 415W (1fps = 5,39W)

2800MHz olałem bo już 2700Mhz zamyka Power Limit.

3840x2160, Cyberpunk 2077, all Ultra, bez RT, FSR Off, inne durepele off (AFMF itp). Lokalizacja industrialna bez zmiennych w postaci tłumów/samochodów a przy tym katująca niemiłosiernie GPU.

VRAM na sztywno przy 2714MHz 'Standard'.

Core Voltage: 1120mV (by wykluczyć potencjalny wpływ niestabilności, aktualnie na Elden Ringu doświadczyłem jednego unstable crasha przy 1100mV)

Fan speed = 100% by wykluczyć wpływ temperatury (gpu core ok. 50*c, hotspot 60-75*c zależnie od TDP)

Wnioski:

1) Tani AIB lub słaba sztuka (przegranie loterii silikonowej) = 2400MHz saves the day2) Dobry AIB lub PTM7950 = 2500MHz lub 2600MHz

3) Wbijanie się powyżej

Ciekawostka, 2400MHz + 2814MHz (+100) Memory daje 73-74fps przy marginalnym wpływie na TBP. Jeżeli macie dobre sztuki w kontekście pamięci to warto pójść tą drogą niż babrać się z rdzeniem.

-

1

1

-

-

Godzinę temu, r1023 napisał:

Nie grałem w Avatara ale np Alan na 7900xtx to straszna bieda. A cyberpunk bez Pathtraincingu to zupełnie inna gra.

Był chyba jakiś update ostatnio, który podnosi perf o 10-15% (nie 30% jak deklarują). Always something (can't confirm tho) -

Godzinę temu, Etranger napisał:

1) Ogółem akceleracja LLM poprzed modele GGUF (korzystające z CPU+GPU). Jak ktoś ma hajs może lecieć na GPU-Only ale to wymaga np. 4 szt. 4090'tki lub A100. Tanio nie jest. Coś jak prywatny chat-GPT4 ale dla nie-ubogich z pełną prywatnością danych (local-hosted) i korzystasz z modeli często trenowanych pod konkretne zadania.2) Nvidia często przekracza granicę uczciwej konkurencji nadużywając przewagę konkurencji monopolistycznej (sam rynek to oligopol), często za to płaci ale... i tak im się to opłaca bo kary są rzadkie a ich wartości są żałosne.

3) Kastrat 4090 zmienia sporo bo jest shift w opłacalności per $. Stąd ostatnie doniesienia o boomie na XTX'y w Chinach. A jeżeli to się rozpędzi to nie zdziwię się jak AMD przekieruje część produkcji z NA i EU na rynek PRC przez co u nas wzrosną ceny. Np. przy AI bardzo często pierwsze skrzypce ma VRAM a AMD w RDNA3 posiada rdzenie AI. 4090 będzie wydajniejszy, ale nie na tyle by uzasadnić dużo większy wydatek przy takiej samej ilości VRAM dla większości. Ba, RTX 3090 nadal jest super popularny przy AI. Natomiast największe korporacje, uniwersytety i instytucje rzadowe w Chinach nadal będą ogarniać w jakiś sposób A100. Łatwo obejść sankcje nie będąc zwykłym Kowalskim/Changiem/Smithem.

-

1 godzinę temu, Etranger napisał:

Dlaczego uważasz ze dla zwykłego gracza RT PT i tym podobne sa bezużyteczne, bo chyba o tym piszesz? To w końcu powoduje ze gry wyglądają ....ładnie?

Bardziej tutaj chodziło mi o ficzery "do" RT, które mordują nawet RTX 4090. Ogólnie należy przyjrzeć się wsparciu funkcji od jednego producenta i popatrzeć potem jak wspiera rozwiązania innych. Ewidentnie zapala się tutaj żarówka.

Tutaj nie chodzi o szkolenia ani nic. Aktualizacja FSR 2.1 do 2.2 nie wymagała ze strony CDP nic. A FSR3 dostępny jest od października. W międzyczasie zaktualizowali nawet Intel XESS. A FSR 2.1 nadal gnije (tego syfu nie da się nawet wł., nawet na quality bo oczy bolą, przynajmniej w 4K). Implementacja FSR3 też ponoć (wg. AMD) jest bardzo prosta jeżeli produkt obsługuje już min. FSR 2. Cedep od premiery gry olewa i opóźnia wszystko od AMD, dając wszystkie możliwe wodotryski od nvidii instantem. Jako konsument produktów obu firm (wali mnie nazwa producenta, interesuje mnie opłacalny produkt w danym momencie) niespecjalnie miło patrzę na takie zachowania.Co do OEM różnie bywa, zależy jak sobie producent umani. Sam sprzedając różne produkty mogę powiedzieć że na magazynie są i takie i takie produkty. Nie wiem co za tym stoi, bo raczej średnio optymalizacja kosztów (ekonomia nakazuje oszczędzanie każdego srebrnika). Możliwe też jest że mają po prostu dużo większy uzysk rdzeni spełniających specyfikację 7900 GRE niż się spodziewali a zamówienia od firm sklejających OEM/składaki są mniejsze niż sądzono.

Chociaż sytuacja z 7900 GRE może się teraz zmienić. Na 7900 XTX, 7900 XT, 7900 GRE jest teraz niemały boom w chinach ze względu ban eksportu 4090 (i powstanie kastrata 4090) podczas gdy AMD łaskawie w końcu przyspieszyło ze wsparciem ROCm (akceleracja AI). Sam używam akceleracji ROCm (AI) na 7900 XTX i tbh. jest na prawdę nieźle, szczególnie biorąc pod uwagę ile musiałbym wywalić hajsu na 4090 (4080 odpada ze względu na ilość VRAM).

7900 GRE ma 160 AI cores, nawet pomimo 16GB VRAM jeżeli vendor da dobrą cenę na bulk to znajdą się klienci na multi-gpu.

Co do funkcji AFMF się nie wypowiem, chociaż jestem raczej "anty" fanem takich gimmicków. Czemu? bo to tylko oszukuje i daje kolejną wymowkę dla beznadziejnej optymalizacji. Sztuczne, nieprawdziwe FPS które tworzone są kosztem jakości oraz opóźnień. Ba, wystarczy dodać trochę dynamiki do obrazu i ficzer nagle się wyłącza. Wolałbym dostać 1% lepszą wydajność rasteryzacji niż to.

-

6 godzin temu, Etranger napisał:

Weź pod uwagę że 7900 GRE to model nie dla konsumenta końcowego tylko na potrzeby OEM. A to że im bokiem produkt ucieka to j uż może być problem ze zbyt dużą podażą tej wersji lub "wyciekiem" przez dystrybucję pośredników. Ref do Nokii dość mocno wyrwany z kontekstu bo brakuje tu realnej analogii.

Co do wydajności to raczej bij z tym do deweloperów, którzy są beznadziejni co pokazywali niejednokrotnie. Ba, nawet gry nie łaska zaktualizować na FSR 2.2, a FSR3 pomimo zapowiedzi olali. Gra ciągle gnije na beznadziejnym FSR 2.1 pomimo że nawet XESS'a aktualizowali kilkukrotnie. Ewidentnie wygląda to jakby robili to by przypodobać się NV, wokół której skaczą jak małpy w ZOO z ich useless dla zwykłego gracza ficzerami.W GRE srogim bottleneckiem jest też VRAM, a dokładniej jego mierna prędkość i ograniczone OC. Chociaż można się tego spodziewać po GPU, z założenia, do gotowców.

-

Przyszedł "pasto-zmienny-prawie-termopad" PTM7950.

Efekt? Ciągle nie wierzę.Przy OC 390-415W (max PL) temperatury hotspot spadły o 12-14*c. I to nie mówię względem stock pasty, bo byłaby jeszcze większa.

Względem SYY-157. Którą... i tak zaatakował efekt pump-out co od razu zauważyłem przy demontażu. Jeżeli SYY(TGX) wypompowało to żadna pasta nie wytrzyma. Zobaczymy jak ten "cud" ponoć "niepodatny" na pump-out da radę.

Ale to, że przy 415W PL temperatury hotspot spadły o ponad 10*c to... ciągle tego nie rozumiem. Myślałem, że ludzie na necie (reddicie) lecą sobie w ciula.

Ba, 10*c mniej przy 500rpm mniej bo mam teraz max 1800rpm zamiast 2300rpm na swoim profilu max oc.

Oczywiście 4K@144 więc maksymalny katung.

Update. Po około 4h wygrzewania w WoWie, CP2077i ok. 7h pracy biurowej temperatury hotspot spadły z 92*c do 85*c - ta sama temperatura w pokoju. Odczyt max po 40m gry.

Co ciekawe, niech mi ktoś tutaj to wyjaśni. Undervolt "wzrósł" z 1120mV core na... 1080mV core. 1070mV niby stabilny ale przy 1060mV crashuje raz na +- 15 minut. Wiec bezpieczna granica to wstępnie 1080mV. Wtedy hotspot spada do 83*c.

Wstępnie nowy stabilny profil Overclock (3840x2160, 144Hz)

Core min. 500MHz

Core max. 2800MHzVoltage 1080mV

Memory: 2764MHz (2750MHz effective), 'standard' timings

PL: +15% (415W max)

Przy 415W (!) delta wynosi teraz maksymalnie 22-23*c. Wcześniej (po wymianie stock pasty anyway) było to ponad 33-37*c. O stocku nawet nie chcę mówić bo ręce opadają.

Przy max temp customowa krzywa wentylatorów nie przekracza 1990rpm.

Wentylatory bottom_case (2x140mm BeQuiet SW4) kręcą się wtedy na max. 920rpm.

Wentylatory frontowe (180mm) kręcą się wtedy na max. 600rpm (są one ustawione combined pod zarówno temp CPU jak i GPU, zależnie od "najgorętszej" krzywej zwiększa wtedy rpm)(screen testowo ma 2700MHz mem, na chwilę zmniejszyłem by ograniczyć wpływ zmiennej na ew. stabilność nowego uV)

-

1

1

-

2

2

-

-

W dniu 28.12.2023 o 12:11, Etranger napisał:

Wystarczy podłączyć drugi monitor do ostatniej serii Radeonow żeby pobór mocy w idle skoczył z 18W do 100W, w ostatnich sterownikach piszą ze to naprawili, ale chyba cos im nie wyszło.

I o ile przy graniu staram się bardzo zrozumieć blisko 400W dla karty, tak kiedy nic się nie dzieje na ekranie 100W to raczej lekka przesada, karta wykręca wtedy maksymalne taktowanie dla pamięci i tylko dla pamięci.

Od końca 2022 przeszedłem przez 1070, 1070SLI, 1080TI, 3070, 4070 i w zasadzie problemów nie było, czasami tylko po jakimś update cos się porobiło z sterownikami i trzeba było kombinować, a ze generalnie piec dla mnie to zabawka wiec instalowałem jedne sterowniki na drugich i w 99% działało bez problemu.

Być może były jakieś spadki mocy ale przy 60Hz to było pomijalne.

No i ja nie gram online gdzie potrzeba pincet klatek.

Problem dawno naprawiono. Mój głowny to 31,5' 4K 144Hz a drugi 27' 60Hz i jest git. No chyba że odpalę dwie różne tapety animowane na wallpaper engine, wtedy jest "funny". Single-monitor z VRR też działa prawidłowo. Większość problemów naprawiono w okolicach sezonu wakacyjnego.

7900 XTX na optymalnych zegarach żre max 250-330W (somehow do 350W na BF 2042 - nie wiem czemu) zależnie od gry.

Przy pracy na jednym ekranie (drugi off) GPU normalnie żre <20W. Przy video playback'u (2160p) klasycznie 50W-60W jak na każdym Radeonie z 16-24GB VRAM.Problemy zawsze były i będą w przypadku każdego producenta GPU. A przymykanie oka na jednych lub drugich to zawsze jedna z pierwszych oznak fanboystwa (niestety nie ma jeszcze na to terapii).

-

Zestaw pamięci RAM DDR4, 32GB KIT, 2 moduły po 16GB

CMK32GX4M2Z3600C18 (AMD)Cena BMK: 250 pln + KW (mała paczucha więc sugeruję inpost)

Info ode mnie: na 5800X3D chodziły przy 1.42V (old agesa) i 1.35v (updated) zależnie od wersji BIOS mojego mobo. Podobnie (1.42v + stara agesa) miałem wcześniej przy 5600X. Jeżeli pamięci nie wstają po włączeniu XMP/DOCP 3600MHz trzeba podnieść napięcie do 1.42-1.43v na niektórych płytach głównych i będzie git nawet bez aktualizacji bios.

Testowałem je też chwilowo na B760 Tomahawk z 13400F i chodziły na XMP 1.35v bez problemu.

Nieaktualne. Ram poszedł w zrujnowany świat po koalicji 8 gwiazdek.

-

Nie wiem jak Alien, ale wiele ekranów PC/laptopów używa PWM. O ile TV mnie nie męczą o tyle monitory i laptopy z OLED bardzo szybko mnie męczą.

Ale nie może to uszkodzić wzroku, co najwyżej zmęczyć i przyprawiać o ból głowy migotaniem. -

-

3 godziny temu, willow1986 napisał:

Szanowni,

Kilka dni temu odebrałem nowego desktopa z RTX 4090, który głównie ma służyć do obróbki wideo (monitor tez nowy - IIYAMA G277OQSU IPS 165 Hz). Ponieważ materiały do pracy przyjdą mi dopiero za tydzień, postanowiłem przetestować go w grach. Tutaj bez problemu. Gorzej jeżeli chodzi o wideo. Stream na Netflixie działa płynnie, ale co jakiś czas wyskakują albo czarne kwadraty albo cały ekran na 2-3 sekundy staje się czarny, ewentualnie następuje "Freez", a po nim gwałtowne przyspieszenie. Sterowniki aktualne. Ma ktoś jakiś pomysł?

Może problem z HEVC lub coś jest nie tak z HDCP 2.2?

Problem występuje tylko przy streamingu HDCP (netflix, amazon, disney)?

-

Noctua NH-D15s (z jednym wentylatorem). Kupiłem ją dla GPU clearance i RAM clearance. Imo best cooler jaki miałem, chociaż wizualna brązowa kupa przy Dark Rock Pro 4 (blokowało mi zawsze blokadę GPU... potem baw się by ją wyjąć). A AiO było upierdliwe.

Obudowa Fractal Torrent Compact, we Fractalu 7 Compact miałem z 10*c więcej na CPU. Obudowa robi sporo bo basicowo mam teraz jeden wielki tunel aerodynamiczny z tornadem.Masz uV na -30 All Core (krzywa)? Do tego ustawić SoC Voltage na zakres 1.1v (ok. 1.118) - 1.05 (1.064) [nie używam LLC przy SoC voltage]. Bardzo mocno wpływa to na pobór prądu i temperatury przez co zegar dużo częściej boostuje pod swój limit.

Co do taktowania zauważyłem minimalne spadki powyżej 75*c. Obecnie raczej nigdy nie przebijam 60*c za wyjątkiem syntetycznego AVX2 (ok 120W, temperatura w 1 sekundę skacze do 78*c i się utrzymuje w przedziale 78-80*c przy tym TDP) oraz Battlefielda 2042 (do 70*c).

-

...........................................................................................

Update nr 4938538539

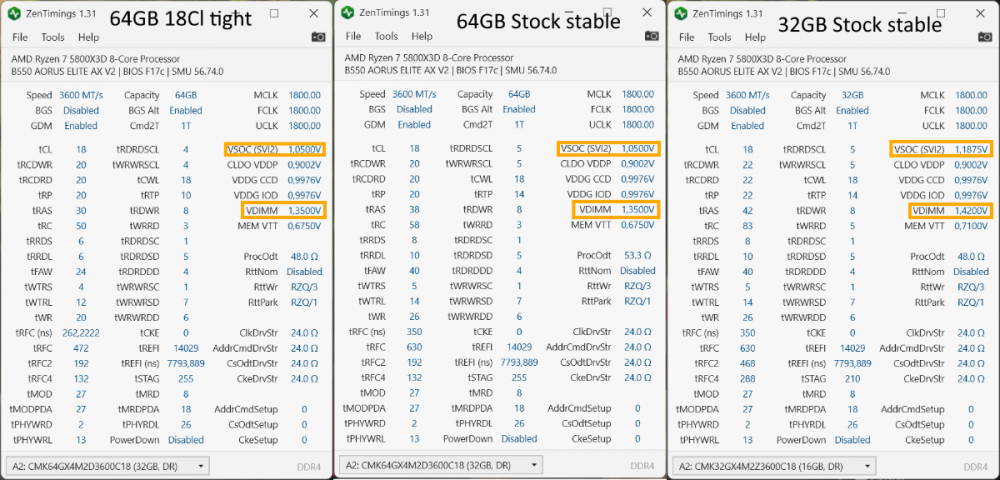

Dzień 2: drogi dzienniczku, udało się znacznie poprawić timingi oraz subtimingi dla Cl18 przy zachowaniu 1.05v SOC oraz 1.35v DIMM. Niestety GDM Disabled instantowo crashuje windowsa, ale przynajmniej komputer bootuje.

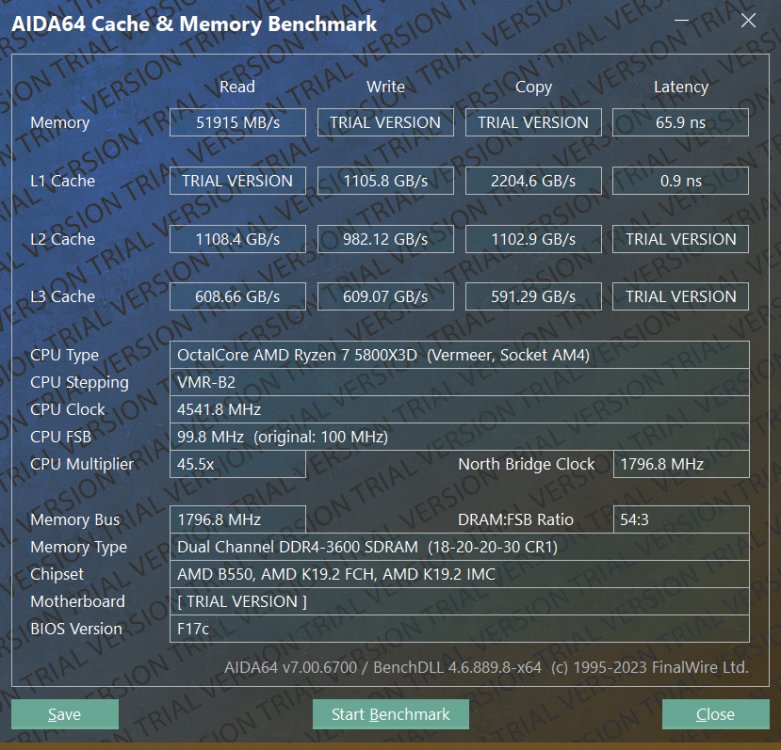

Porównanie: obecny stan 2x32GB (poprawione 18Cl przy niskim napięciu) vs 2x32GB stable stock (stock ustawienia oraz najniższe rozsądne napięcia) vs stary zestaw 2x16GB, który nie lubił się z moim mobo (na tomaszu hałku np. działał lepiej).

W OCCT przy typowych programach działających w tle latency spadło z 86ms na 77ns. Wzrosła też trochę przepustowość.

EDIT: 64GB "Stock stable" to nie do końca stock, było 18-22-22-22-44-64 około. Teraz się skapnąłem że to było już dłubnięte. tRFC też było 990 zamiast 630 na stocku.

Pobrałem też aidę ale nie lubię jej. Wolę brutalne pomiary OCCT w realnych warunkach.

Pobity został nowy personal rekord

https://www.3dmark.com/compare/spy/43029995/spy/43694463

-

-

18 godzin temu, ernorator napisał:

3600MHz raczej nie ulegnie zmianie. A on w większości na tym się skupia. Szukałem trochę postów o samym latency i opóźnieniach ale zazwyczaj są one zbyt chaotyczne i niemiarodajne. Najwyżej sprawdzę empirycznie i tyle, o ile uda się zejść do 16Cl a najlepiej 14-15 przy 3600.

Z podnoszeniem IF nie będę ryzykował, nie mam aż tyle czasu ani chęci na zabawę ze stabilizacją SOC.Aktualizacja:

przyszedł Ram 2X32GB Korsarza i... jestem pozytywnie zaskoczony.Poprzedni kit 2x16GB wymagał na moim IMC & Mobo 1.43v do bootowania i stabilnego działania. kit 2x32bit śmiga na 1.35v bez problemu.

SOV Voltage jest stabilny na 1.0875v co mnie turbo zaskoczyło. Jak nie będzie WHEA i innych cyrków to spróbuję zejść do 1.05v.

Na start dało się zejść z 18-22-22-22-42-64 na 16-19-19-19-30-49 (et ceteris paribus) i po 20m zdaje się być full stable. We'll see.Może uda się zejść do 16-16-16-16... nie wiem jak z tRAS i tRC.

tzn. TRAS, bo TRC to chyba było tRP plus tRAS

Add (kolejny raz).

Jednak 18-22-22-22-42-64 wywaliło BSOD'a w BF 2042 (gra idealnie katuje CPU z RAMem). Chwilowo wróciłem do stock ale za to udało się stabilnie zejść do 1.05v SoC.Teraz można się bawić z timingiem. Ale to będzie irytujące...

18-20-20-38-58 przy 1.35v oraz 1.05v SoC vs stary kit 32GB który nie lubi się z moim mobo 18-22-22-22-42-83 (tRC powinno być 64 ale coś słabo się wytrenowały...). Udało mi się też w miarę poprawić lub wyrównać subtimingi na wzór xmp. Dalsze ruszanie tRCD i tRP skutkuje tym że mobo nie wstaje.

Temat o kartach graficznych INTEL, aka trzeci gracz

w Karty graficzne

Napisano

Też trochę snobistyczne, biorąc pod uwagę że większość osób tutaj żyje w Bolzdze to raczej sporo by umarło z głodu albo nie byliby w stanie opłacić czynszu gdyby kupili sobie RTX'a. Nie każdy gra też w tytuły z np. RTX czy DLSS/FSR (whatever you pick). Większość gier, która skupia większość rynkową (tytuły online) nie obsługuje takich gimmicków i nigdy nie będzie. Anomaly still persists.

Anomaly still persists.

A i funfact: RayTracing (po roku mogę to potw.) w World of Warcraft nadal działa dużo lepiej na FSR3 niż RTX'ach.

DLSS i FSR, jakikolwiek framegen to syf, który najlepiej zaorać, wszyscy w długim okresie przez to "przegramy". Lenistwo deweloperów + degradacja jakości obrazu c.d.

To jest ich super tania metoda zwiększania rozmiaru słupków na wykresach podczas premier oraz w papirusach marketingowych.

Wniosek: każdy producent to menda i każdego z nas... nie powiem co. Fishsticks w pączusia.

Co do perf per watt realnie jest h2h jeżeli ktoś umie robić uV i rozumie jak działa core frequency i skalowanie na RDNA3. Ba, w ciągu zaledwie tylko tego miesiąca RX 7900 XTX zaczął rywalizować z potężnym RTX 4090 w akceleracji AI (last dwa update'y ROCm). A do tego value per €.

Dla każdego coś się znajdzie, robisz A to kupujesz AMD, robisz N kupujesz NVIDIE. Wiesz dokładnie co robisz, np. "I" to kupujesz taniego Intela Arc'a A770 bo ci styknie i wiesz że tutaj sterowniki cię nie storpedują. Różne potrzeby, różne budżety. Jedyne czym gardzę to fanboystwo.