-

Liczba zawartości

2048 -

Rejestracja

-

Ostatnia wizyta

Typ zawartości

Profile

Blogi

Forum

Kalendarz

Posty dodane przez Revenant

-

-

6 minut temu, Rebelmind napisał:

@GAMER G1zastanow sie nad sensem i celem wymiany, bo 5800x3D tj nadal prawie 1400 PLN. 7800x3D juz widzialem ponizej 2000 PLN i tj jednak prawie 30% szybszy proc w 2K (o ile dobrze pamietam Twoj monitor). O 5900x to totalnie zapomnij, bo nie zobaczysz zadnej roznicy.

W PL realnie 2300.

Do tego dolicz bardzo drogie mobo i x2 droższy RAM. Imo bezsens inwestować w AM5 na chwilę obecną.A różnica w wydajności nie ma żadnego sensu w przypadku grania. Low'y będą podobne i nikt zdrowy na umyśle nie gra przy 300-400fps. Górną granicę fps zazwyczaj i tak wyznacza karta.

Mieć szybszego cepa (i x2,5 droższego)... ale po co?

-

1

1

-

-

Diablo 4 przy 4K@Ultra na RX 6800 (OC+UV) rock-solid 60fps.

Ale aż oczy pieką na widok, że gra zżera ciągle 16GB VRAM non-stop, ale bez chamskiego doczytywania jak np. w D3. W końcu ktoś pomyślał by wykorzystać VRAM, jeżeli się da?

na RX 7900 XTX kumplowi ciamka 19GB VRAM.-

1

1

-

-

Niestety, rynek wygląda jak wygląda. Czasami warto nawet poczekać chwilę i dozbierać te kilkaset złotych i kupić coś wielokrotnie lepszego i rozsądnego.

Od biedy czekać na RTX 4060 8GB, jest szansa że zejdzie do 100W po uV (zakładając, że będzie możliwe). Ale specyfikacja tej karty to kpina. Tak jak 4060Ti czy 7600.

-

Porządnym liderem bazując na rozsądku jest RX 6800 (bez XT). Po UV bez problemu można zejść do 170-190W zależnie od sztuki (w rzadkim przypadku nawet niżej) ciągle posiadając 16GB VRAM.

Jest nadal mocniejszy od 7600, 4060, 4060 Ti (dużo mocniejszy, a tym większa rozdzielczość tym bardziej rośnie przewaga). Pobór prądu jest podobny. Ma szynę 4.0 x16, 16GB VRAM. Ogółem jest to mega zbalansowana karta pod względem ceny x wydajność x future-proof x efficiency.

Jest jeszcze RTX 4070 ale ma np. 12GB VRAM i jest o ponad połowę droższy. Osobiście bym go olał (chyba że nagle spadnie cena o kolejne 30%).

-

1

1

-

-

Szukaj używki 6800, 6800XT, 6900XT, 6950XT. Szkoda hajsu na nowe a mają drama dobre perf per € i perf per watt (szczególnie 6800 który po UV zjeżdża do 170W-190W TBP) + 16GB VRAM.

Z nowych od biedy RTX 4070 ale ma 12GB VRAM. do 1440p raczej styknie (nvidia ma chamską kompresję więc nie będzie źle). Ale średnio przyszłościowa opcja i na pewno nie do 2160p.

Alternatywnie: czekanie na price drop 7900 XT lub 7800/7800XT (nie wiadomo kiedy będą - i czy w ogóle)

-

20 godzin temu, zbiku90 napisał:

Pytanie tylko na ile to sztuczna inteligencja, a na ile zaprogramowane algorytmy? Czy taki zestaw AA jest zdolny się uczyć w oparciu o własne doświadczenia? Mi bardziej chodziło o jakieś symulacje czy analizy na poziomie strategicznym.

Jak na razie każde istniejące AI to zbiór algorytmów. Raczej chyba jeszcze nie stworzono (albo o tym po prostu nie wiem) układu z prawdziwymi sieciami neurowymi zdolnymi do "takich akcji".

System AA raczej na pewno nie bazuje na swoich danych, nawet nie jestem pewien by w ogóle może zapisać & odczytać outcome poza logami.System kierowania ogniem (np. F35+F15EX) z tego co czytałem prawdopodobnie ma takie możliwości w ograniczonym stopniu - ale to still mocno ograniczony algorytm i nic więcej.

Nawet drony w ramach FCAS (itp.) będę się pewnie opierać na zwykłych algorytmach.

-

23 minuty temu, zbiku90 napisał:

Daję sobie obydwie ręce uciąć że AI na przeróżne sposoby jest wykorzystywane w wojsku od dawna. Póki nie ma siły sprawczej, a tylko pełni np. funkcje doradcze to jesteśmy bezpieczni

Bo pewnie jest. Od ponad dekady np. USA, UK i FR palą tony petrodolarów np. nad programami związanymi z dronami. Wiele systemów kontroli ognia można byłoby podpiąć pod tą definicję, a szczególnie systemy w siłach powietrznych i rakietowych (np. tryby automatyczne S300 czy Patriotów - nawet tych starszych). -

1 godzinę temu, Rebelmind napisał:

Ty pamiętasz, że 7900 XT tj średnio 8% szybciej niż 6950 XT? Ani RT nie jest jakoś dużo lepsze, ani sprawność energetyczna / pobór mocy wyraźnie lepszy. Poza tym, gdy 7900 XT spadnie do 3500 PLN to 6950 XT zleci gdzieś pod 2700. Warto dopłacać?

AV1 oraz wydajność w kilku grach, w które muce jest dużo większa.

Ogółem w 1440p są bliżej siebie. Ale przy 2160p 7900 XT wyciąga większe różnice.

Np. TW:WH3 (6950 od 6900 będzie wyciągać max 2-3fps więcej):

-

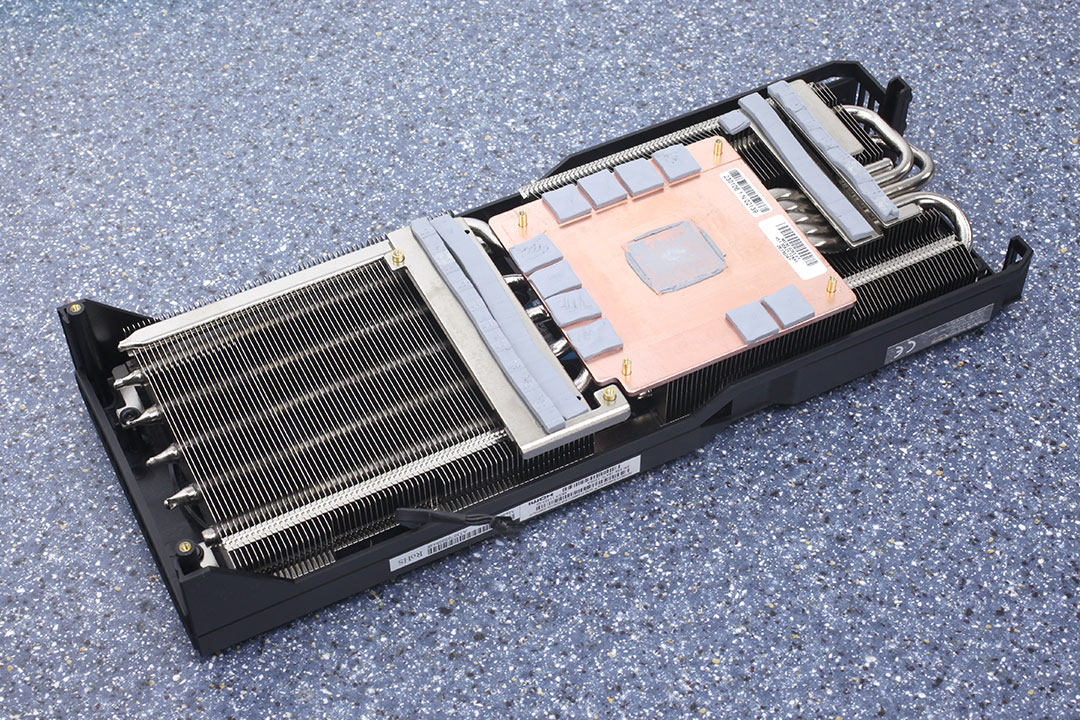

Wygląda jak zwykły copper plate

-

14 godzin temu, Rebelmind napisał:

Nitro i Merc mają, co do Pulse nie jestem pewien ale WYDAJE MI SIĘ, że tj ten sam schemat co wcześniej: tj dokładnie to samo chłodzenie co w Nitro tylko 1-2 heatpipy mniej

Pulse chyba nie ma, oglądałem parę dni temu jedną recenzję i jak rozkręcano kartę i chyba był tam zwykły copperplate.-

1

1

-

-

Ma ktoś szklana kulę?

Będę się powoli przymierzał do zakupu 7900 XT w czerwcu-sierpniu.I mam rozkminę: referent czy Pulse?

Wszystkie testy, które czytałem wcale nie pokazują jakiejś wybitnej przewagi Pulse'a (który jednak jest droży o kilkaset zł). A referent przy odrobinie dopieszczenia i normalnej krzywej wentyli staje się fajny.

Za 3500pln + TLOU bym szarpał

-

4 godziny temu, wrobel_krk napisał:

Całkiem podobnie jak moja przesiadka z 3700x na 5800x, w 3440x1440 raczej średnie fps nie poszło w górę ale dropy/stabilność tak, ale ja już raczej jak zmienię to zen5 bo 5800x3d to chyba tylko jak się trafi jakaś okazja albio jakaś gra mnie wciągnie gdzie zobaczę różnicę z rtx3080. Ciekawe że zamiana 5600x na x3d w 4k z rx6800 też coś Ci dała w 4k, ja na razie nie widzę za bardzo cięć w grach ale gram teraz w god of war/ diablo 4 testowałem czy Wieśka 3 bez RT.

Co do płyt to ja ostatnio głownie biorę MSI, b450 a-pro max - super płytka była, b550 torpedo tez wszystko śmiga,. Na Intelu jak składaliśmy dla programisty 12600k na Gigabyte B660M DS3H i też bez problemów. Wiec jak dla mnie MSI/Gigabyte najpewniejsze, co nie znaczy, że nie ma wpadek:)

Z top-fps raczej nic się nie zmieniło. GPU jest hard bottleneckiem.

Ale w większości gier, w które gram zdecydowanie poprawiły się 1% & 0.1% low. Szczególnie World of Warcraft Dragonflight, który ma upośledzony i przestarzały engine.

W TW:WH3 w benchmarku niby zero zmian, ale już in-game mając "mini-doomstack" z 5 Dreadquake Cannonami od razu widzę poprawę bo przy salwie fps'y spadają mi do 50-40 a nie 5fps (na 12700k też spada do dna wtedy). Tak więc w niektórych grach zmiany są raczej zależne od scenariusza ale to jest kolejna poprawa "quality of life".

Jeżeli w wakacje 7900XT spadnie do 3500zł to będę szarpał upgrade. Bo raczej nie liczę na to, że 4080'tka spadnie do 4000zł

Bo raczej nie liczę na to, że 4080'tka spadnie do 4000zł

Przy 5600X miałbym trochę wyrzuty sumienia ale na 5800X3D już nie. I zawsze mam te 2 dodatkowe rdzenie (po co - jeszcze nie wiem). -

Wymieniłem dziś 5600X (4.85GHz all-core boost) na 5800X3D.

Bios zaktualizowany do F17c (odblokowuje krzywą uV w biosie dla 5800X3D).

W CB R23 -100pts na single core, 1483 vs 1580 (jednak te 400MHz różnicy jest). Ale... cep śmiga na -30uV (5600X chodził na -22, -15, -28, -28, -28, -17).-

W WoWie odwalił się cud, full stable 60fps nawet w Valdrakken.

Redukcja dropów o 99% włącznie z world bossami i epic battlegrounds, full płynność.

Redukcja dropów o 99% włącznie z world bossami i epic battlegrounds, full płynność.

- Hell Let Loose nie odnotowałem szarpnięć podczas ostrzału artylerii.

- HOI4 z modem Millennium Dawn trochę (odczuwalnie) mniej zamula na cotygodniowym podliczeniu danych.

Jeszcze nie przetestowałem innych gier. W kolejce jest TW:WH3 oraz Cyberszrot.

Co ciekawe:

Temperatura w grach:

5600X - 70-74*c (pasta noctua stock NH-D15s, idealna aplikacja)

5800X3D - 51-53*c (pasta SYY, idealna aplikacja)

Ten sam profil CPU-Fan, przy czym na 5800X w ogóle się nie rozkręca (do 60*c mam flatline +-820rpm). NH-D15s.W Cinebenchu R23 temperatura to max 77.3*c (3 próby, hottest core). Przy 5600X było to 75,5*c (3 próby).

Założenia:

1) Mam już dobrą platformę, szkoda hajsu na AM5. (po sprzedaniu 5600X dopłaciłem ok. 700-720zł - bez kosztów całej nowej platformy...)2) Gram w 4K@60. Więc chcę zminimalizować fps-dropy (walka o 1% low i maksymalizację GPU-utilization).

3) Korzyści z 3D Cache są takie same w przypadku 4K jak przy Zen4 3D Cache. Jakiekolwiek korzyści z top-fps są tutaj guzik warte (nawet jak kupię monitor 120Hz to raczej i tak nie będą mnie interesować walki po 180, 400 czy 700fps jak przy FHD bo karta jako pierwsza się udławi).4) Nawet przy dobrej sztuce 5600X i OC+UV czułem dropy (1% low, 0.1% low) w 4K. Niestety u AMD jest to odczuwalne czego nie powiem o np. Intelach 12gen, które macałem (składałem i testowałem). Na 5800X3D atm. w końcu jest święty spokój i max płynność.

5) Nie będzie bottleneckiem dla 7900XT ani raczej następnej generacji (przy 2160p).

Bonus feature: Nie mogę nic podkręcić. W końcu będę więcej grał a mniej dłubał.

Chyba że... pobawię się z timingami ramu.

Chyba że... pobawię się z timingami ramu.

I trochę płynniej się pracuje w Resolve przy składaniu i edycji. Co do kompilacji nie wiem - pewnie wolniej od 5800X ale i tak mnie to wali bo wtedy wychodzę z pokoju. A power used per job pewnie lepiej wypada 5800X3D przy tym chorym uV.

Trochę pokrywa się to z tym:

-

4

4

-

W WoWie odwalił się cud, full stable 60fps nawet w Valdrakken.

-

5 godzin temu, Rebelmind napisał:

Tak właśnie liczyłem, że wystarczy iż znajdzie się jedno nawet quasi-popularne zastosowanie, w którym Intel przelamie totalny duopol (zaoferuje zauważalnie lepsze osiągi przy konkurencyjnej cenie lub podobne za wyraźnie niższą) i Alchemist będzie brany.

Czy tj istotne w tym temacie czy mylę pojęcia? https://www.tomshardware.com/news/intel-arc-av1-encoder-dominates-nvenc

Tbh specem tutaj nie jestem, niewiele mi to mówi. Wolałbym bezpośredni test na próbce w w/w programach przy zastosowaniu popularnych formatów i ustawień. Ja tylko montuje filmiki dwóm jutuberom, nie jestem inżynierem.

Chciałbym zobaczyć starcie np. 6700XT, 6800/6800XT, 3060 (ze względu na 12GB VRAM), Arc770 przy:

1) 2160p, 80Mbps, DNxHR (docelowo potem leci handbrake'iem na H.264, ale export pierwotny w DNxHR)2) 1080p, 15-20Mbps, H.264 (typowy casualowy format dla zwykłego śmiertelnika, non-pro)

I obstawiam, że RTX 3060 wypadłby tutaj "najtaniej" (tzn. najlepiej dla zwykłego śmiertelnika) przez CUDA i VRAM. ARC jest dla mnie niewiadomą atm.

Taki 13700K + ARC770 mógłby być fajną platformą do pracy (zakładając że nie spartolili akceleracji w normalnych warunkach).

Nie wiedziałem że Tech Jezus testuje już gry na TW:WH3. I szczerze mówiąc wynik A770 jest... nawet dobry?

Imo nie jest tak źle, spodziewałem że się będzie gorzej. Może jednak w ciągu 2-3 generacji coś z tego będzie (chyba że Intel zrezygnuje).

-

Są gdzieś wyniki akceleracji Intelowego A770 przy obróbce wideo? Blackmagic (Resolve Studio) albo Adobe (Premiere Pro)?

Wszędzie tylko "gadajo" o graniu, a pokazali by obróbkę wideo. nGREEDia ma CUDA, AMD ma akceleracje... a Intel? :|

-

6 minut temu, Arnold napisał:

Do jakiego sprzętu?

Edifiery R1700BT, stwierdziłem że nie ma sensu droższych. Obecnie mam Prolinki Futury ale 1,5m i potrzebuje czegoś x2 dłuższego. Teraz wpadły tanie Vitalco.

-

4

4

-

-

-

Upgrade dla moich monitorów z serii UL od LG (27' 4K).

Nowy model 27UP. Dochodzi DCI-P3 i lepszy kontrast 1200:1. Ciekawe jak wypadnie w porównaniu ze starszymi braćmi.

-

5

5

-

3

3

-

-

3 minuty temu, wrobel_krk napisał:

Przy czym Zen3 ciągle jest dużo tańszy (i sporo ostatnio promocji na te procki jest, przynajmniej w DE). Koszt np. mobo dla Zen3 jest ciągle tańszy niż dla 12gen.

Według mnie Zen4 przegra ten pojedynek i to solidnie z 13gen. Tracą swoją największą zaletę. Sam pobór ma wpływ na koszt platformy, tj. BOM (bill of materials) płyt głównych. A każdy półprzewodnik praktycznie zdrożał w ciągu ostatnich 2-3 lat (np. VRM, doublery itp).

Sam fakt znacznego podniesienia TDP przy 7600X oraz wprowadzenie odpowiednika PL2 Intela to pokazuje. Jeszcze żeby był Cache 3D to by to uzasadniało - a tak to lipa. Intel ma jeszcze efficiency cores co jest zaletą jakby nie patrzeć. A integra Zen4 zdecydowanie nie jest żadnym wybitnym bonusem bo jest dość... słaba.

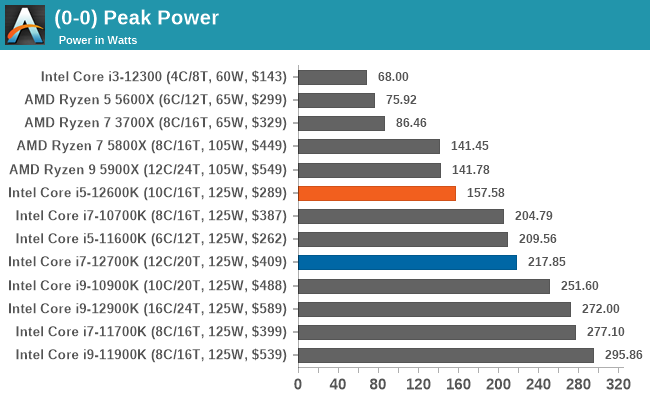

5600X - 65W (PP 70-75W)

7600X - 105W (PP 140W, do tego dodajmy PBO i luźne limity na wielu płytach i zrobi się więcej)

12600K - 125W (PL1)

Zakładając, że i5 (odblokowana oczywiście) będzie miała jak dotychczas bazowo 125W PL1 to 7600X nie jest jakoś wybitnie oszczędny. A warto wspomnieć że Intel ciągle gnije na 10nm...

Za niecały miesiąc się dowiemy. Swoją drogą samo dzielenie chipsetu u AMD na X670 i X670E to kpina...

-

10 minut temu, wrobel_krk napisał:

To Ty tez prezentujesz billboard taki ale w druga stronę, bierzesz taka grę jaka ci pasuje, gdzie 90% gier będzie podobnie jak w testach poniżej.

5600x bierze mniej prądu ale 2 końcu to jest 6/12 proc z 88w tdp, gdzie takie 12600k .

12700k czy 12900k biorą kapkę więcej, co nie zmienia faktu że są wydajne:)Jak popatrzysz na wykresy z fps per wat to jeszcze lepiej się prezentują intele 12gen bo wyciągają więcej fps-ów niż 5600x:)

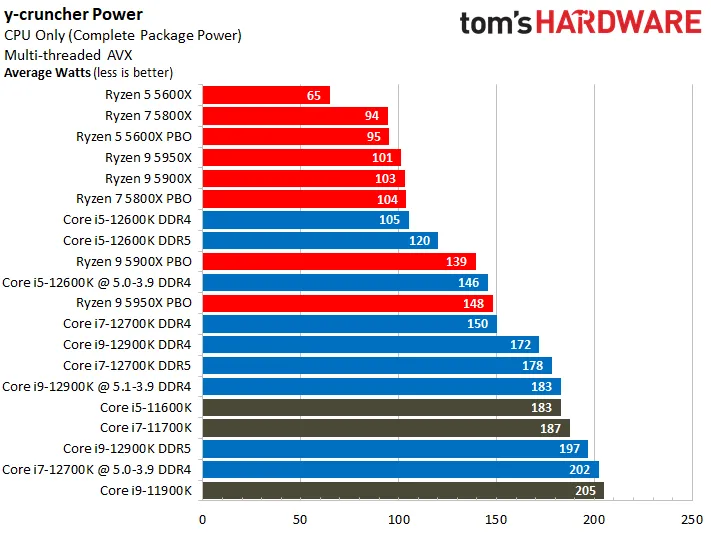

A to że Intel jest wydajny to nie neguję, jest mocniejszy. Ale problem w tym że większość tych gier nie jest w ogóle CPU intensive i nie korzysta z wielu obciążających instrukcji. Jak chcemy mierzyć prawdziwą wydajność współczesnych procesorów względem poboru prądu to należy to testować na relatywnie nowych tytułach, które korzystają z API wykorzystujących nowe instrukcje CPU. Jaki jest sens testować CPU na grach, które przez developera były robione pod GPU na poziomie designu i optymalizacji? To tak jakby testować Priusa na Nurburgringu.

A nie testować to na bardzo starych grach. Do takich gier nawet nie trzeba wypasionego procesora.Mamy tytuł z 2022 roku - Total War Warhammer 3. Idealnie "szmaci" wszystkie procesory równo. Silnik wykorzystuje większość instrukcji oraz bardzo dobrze obsługuje procesory multicore. Obok niewiele starszy Cyberbug 2077 po patchach oraz Microsoft Flight Simulator.

Przy okazji takiego testu wyjdzie też prawdziwa, dużo większa wydajność względem starych procesorów, które mogą nie wyrabiać przy niektórych instrukcjach. I tutaj Intel powinien sobie radzić najlepiej (np. mój ulubiony Skylake - ciągle uważam 6700K za jeden z best procków po Sandy Bridge [2600k/2700k]).

Co do testów Igorslaba, mają dość słabą metodykę. Lepsze testy robi TPU oraz Guru3D. Ew. Techjezus (GN).

Cyrk to się zacznie jak wyjdą 13gen Intele i na rynku de-facto będziemy mieli Zen3, Zen4 i 13gen jednocześnie. I obstawiam, że Zen4 będzie tym najgorszym wyborem...

-

23 minuty temu, r1023 napisał:

To nie są gry CPU intensive. Byle jaki procesor będzie miał taki pobór prądu.

23 minuty temu, r1023 napisał:A jeżeli zakładasz ze 12700k ma na pulpicie w idlu 50W to pokazuje że chyba cos jednak Ci nie poszło z tym intelem że tyle miałeś, bo zakładam że jak coś piszesz to z doświadczenia a nie obrazków z netu.

Nadal nie rozumiesz co to sarkazm. https://sjp.pwn.pl/slowniki/SARKAZM.html

Bo nic nie pisałem o 50W w buildzie, który składałem.

Bo nic nie pisałem o 50W w buildzie, który składałem.

Idle power jest bez znaczenia, każdy modern cpu pobiera wielkie g. Tak samo jak gry, które nie są CPU intensive.Odpal sobie np. TW:WH3 przy 80 unitach w bitwie [2 armie vs 2 armie reinf.] (settings -> unit size -> large unit size oczywiście) to zobaczysz ile cyfr będzie miała wartość poboru prądu 12700K. Od razu mówię że będzie to wysoka wartość 3 cyfrowa jeżeli GPU nie będzie bottleneckiem.

testowałem na tej grze 5600X, 5900X, 12700K. Gra przy okazji brutalnie weryfikuje stabilność CPU przy OC/UV. Nie ma chyba lepszego tytułu do testowania CPU obecnie.

testowałem na tej grze 5600X, 5900X, 12700K. Gra przy okazji brutalnie weryfikuje stabilność CPU przy OC/UV. Nie ma chyba lepszego tytułu do testowania CPU obecnie.

Albo od biedy Cyberpunk 2077 z dużą populacją na Corpo Plaza... też będziesz bardzo daleko od okolic 50W. RDR2? Microsoft Flight Simulator?Nie wyskakuj z takimi śmiesznymi grami do oceniania poboru prądu procesora. Bo to tak jak te billboardy z przekręconymi danymi statystycznymi...

Każdy 1fps generowany z Intela jest okupiony większą ilością prądu niż ma to miejsce w przypadku Zen3. Taki jest fakt. Może być mocniejszy (bo jest), ale co z tego skoro odbywa się to nieadekwatnym poborem prądu? Gdzie dodatkowy koszt plaformy? Wykres z TPU mówi wszystko. A to jest jedna z najważniejszych rzeczy dla zwykłego śmiertelnika. Dodatkowo lepsza sprawność energetyczna = można brać tańsze mobo (VRM) oraz chłodzenie. Łatwiej będzie schłodzić i tak imo gorącego R7 5800X niż 12700K. Undervolting także będzie zawsze lepszy w przypadku Zen3.

Sytuacja będzie inna po wyjściu 13gen vs Zen4, gdzie przez wysoki pobór prądu i temp Zen4 to Intel będzie prawdopodobnie lepszym wyborem (zmiana rozsądnego obozu).

Stan realny na Q3 2022: Best budget & power efficiency friendly: Zen3

Perf per € - Zen3

Perf per W - Zen3

Zen4 nawet nie komentuje, bo AMD zawiodło mocno.

-

1

1

-

-

Nie, to ty nie zrozumiałeś sarkazmu.

Bo 50W na pewno ten procesor nie osiąga przy poważnym obciążeniu, chyba że podzieliłeś przez minimum 3.

Następnym razem pomyśl zanim zabłyśniesz swoimi mądrościami odnośnie power efficiency Intela.

-

46 minut temu, r1023 napisał:

Aha rozumiem. U ciebie full load pod obciążeniem to jest pulpit. Gratuluję. A teraz odpal encoding to zobaczysz ile pobiera. Bez uV zobaczysz praktycznie wartość pełnego PL2 czyli powyżej 200W. Po uV może zejdziesz do 150W jak masz dobrą sztukę.

To by było na tyle z twojego biadolenia. Wybierasz sobie wygodny fragment niczym PiSior na billboardach. Intel żre tony prądu i ma żenujący perf per watt - end of topic.

To by było na tyle z twojego biadolenia. Wybierasz sobie wygodny fragment niczym PiSior na billboardach. Intel żre tony prądu i ma żenujący perf per watt - end of topic.

-

Ja tu przy OC na 4.8 all core martwię się tym że w końcu widzę temperatury rzędu 68-73*c (przy 74W Package Power) a tym czasem Zen4 walczy o stan bez samozapłonu...

Chyba pora przestawić Noctuę z 450rpm na 650rpm.

<meanwhile Zen4 changes rpm from to 6500rpm, laptop style>Jaki limit vcore i temp był dla Zen3 w kontekście degradacji długoterminowej?

Tymczasem Jay tryhardzi z Zen4

Temat o kartach graficznych NAVI 3 / RDNA3

w Karty graficzne

Napisano

Coś ostatnio nie ma obniżek cen RX 7900 XT. Ba, nawet wzrosły ich ceny

Po przecenach typu 3600-3700zł nie ma ani śladu (referenty).