-

Liczba zawartości

1855 -

Rejestracja

-

Ostatnia wizyta

Typ zawartości

Profile

Blogi

Forum

Kalendarz

Posty dodane przez ReznoR

-

-

A to mój DIY:

https://sta.sh/01qwhvypykxv

Xeon E5502. Tańszy niż normalny brelok.

-

Już miesiąc katowania kart 24h/7 (często też podkręcanych, co jest jeszcze gorsze) znacznie obniża ich żywotność. Jak pisałem, unikać lepiej jeśli tylko jest taka możliwość, chyba że ktoś jest totalnie świadomy ryzyka.

-

Osobiście raczej unikałbym w takich sytuacjach allegro i czekał za normalną dostępnością nowych kart.

Dla tych co radzą brać karty pokoparkowe mam dwa słowa - elektromigracja i unikać. Taka karta zwyczajnie padnie szybciej niż nowa i może to nastąpić nawet np. tuż po końcu okresu gwarancyjnego, bo jej okres życia już się skrócił. Lepiej trzymać się daleko od takich "dealów", chyba że ktoś sprzedaje za bezcen i komuś kompletnie nie żal wydania tej kasy. -

Jednak wciąż dziwi mnie to, dlaczego gość twierdzi, że to problem z kartą, skoro działa normalnie jak nowa na innym komputerze. Wydaje mi się jednak, że problem siedzi gdzieś indziej, tylko trudno powiedzieć gdzie w takiej sytuacji. Osobiście wolałbym żeby nikt mi nic elektronicznego nie podgrzewał bez dokładnego sprawdzenia wszystkich opcji. Ingerencją w elektronikę powinny się zajmować profesjonalne serwisy elektroniki, a nie informatycy.

-

2

2

-

-

j.w. inwestowanie w stare sprzęty komputerowe (nawet z topowej półki) to zwykłe wydawanie kasy w błoto.

Od serii Fermi GTX 4xx i 5xx to się trzymać jak najdalej zwłaszcza! Już w momencie premiery to była porażka, a co dopiero po ponad 7 latach.

Co do tematu:

Jak poprosić o pomoc w dziale "Karty graficzne" -

CS:GO i jego mapy są aktualizowane i nie zawsze i nie na każdej mapie będziesz miał tam tyle samo FPS.

Jak wygląda u ciebie wykorzystanie karty graficznej podczas grania? Jest cały czas wykorzystana maksymalnie, czy miewa często spadki poniżej 90% wykorzystywania? Sprawdzasz to np. instalując MSI Afterburner. -

DVI-I == cyfra + analog (można użyć przejściówki)

DVI-D == tylko cyfra (przejściówka nie zadziała)

DVI-A == tylko analog (praktycznie nieużywane złącze)

https://nvidia.zendesk.com/hc/pl/articles/201073551-Jaka-jest-różnica-między-DVI-I-a-DVI-D-

informacje o każdych z typów złącz dostępnych na karcie można znaleźć na stronie producenta karty i w instrukcji obsługi, a o samych typach złącz można poszukać informacji na wikipedii lub na stronach producentów monitorów jak np. Eizo.Mam w opcji initiate graphic adapter 2 opcje do wyboru. IGD i PEG.

IGD == Integrated Graphics Display (karta zintegrowana)

PEG == PCI-Express Graphics Device (twój GTX 780)Aby mieć obraz po podłączeniu GTX 780 musisz wybrać PEG.

-

Jeśli kręciłeś procesor, to możesz przywrócić ustawienia BIOSu do domyślnych, żeby wyeliminować tą kwestię.

Stabilność pamięci RAM możesz sprawdzić np. https://www.techpowerup.com/memtest64/

Testuj conajmniej 20 minut lub do pierwszego errora.-

1

1

-

-

Każdy ma inną definicję co jest ciche a co nie. Mów sobie co chcesz, ale ja już mam porównanie do tego, jak powinno wyglądać prawidłowo zaprojektowane chłodzenie i w porównaniu z tym Asus robi to zwyczajnie "na odwal się", byle wyglądało. To wcale nie jest osobna opinia, o czym wiedziałbyś, jakbyś czytał wypowiedzi na forach i rzetelne recenzje (porównawcze) Strixów właśnie.

Jedyny model z chłodzeniem w nazwie Strix gdzie w końcu zrozumieli swoje błędy i się w końcu poprawili, to wersja GTX 1080 Ti Strix, która zbiera już dobre opinie od użytkowników i całkiem niezłe recenzje.

Na dzisiaj to ledwo co znajdziesz na półkach z kart graficznych...

-

Nie przypominam sobie, żeby kiedykolwiek "popularne" oznaczało "dobre".

Strix jest głośny i się grzeje, ma nisko ustawiony fabrycznie Power Limit, nie ma chłodzonych pamięci i bezpośrednio sekcji zasilania, daleko mu pod tym względem do innych chłodzeń, w dodatku backplate w tej karcie jest cieniutki i nie daje absolutnie nic poza wyglądem, karta masakrycznie wygina się w slocie ze względu na nieprzemyślany projekt stabilizacji chłodzenia przy śledziu - próby trzymania karty w miejscu przy pomocy podpórek skutkowały zwiększeniem temperatur i prędkości wentylatorów ze względu na kiepską jakość użytej pasty termoprzewodzącej i - poraz kolejny - tragicznego projektu całego chłodzenia.

Jedyny plus Strixa to półpasywne chłodzenie i ciekawy wygląd, a plus Asusa to dobry serwis.

Nie, 970 nie bije Radeonów w każdym teście, w dodatku ma też własne problemy, które w niektórych grach bardzo dokuczają, ale o tym za dużo by pisać. -

Daj spokój - karty graficzne z pamięcią "DDR3" (bez "G" w nazwie) nie nadają się do grania. Unikaj ich jak ognia.

Nikt ci nic nie poradzi na to, że teraz takie ceny wysokie - czekaj, aż minie szał na kopanie kryptowalut, lub czekaj na okazję/promocję, bo takiego GTX 750 Ti można trafić za 300 zł bez problemu.

No i j.w. kolega zalinkował takiego HD 7850 2GiB, też solidna karta do grania w D3.

Ew. HD 7770/7790 2GiB można szukać też

a Diablo 3 do lżejszych tytułów się zalicza

Oj nie do końca tak jest

w wiekszosci spokojnych momentów ta gra jest bardzo mało wymagająca, ale jak już dochodzi do obliczeń fizyki (Havok) i zamieszania przy większych grupach (co będzie sie zdarzało bardzo często) to rosną tak wymagania od CPU jak i GPU. Jeszcze bardziej wzrastają wymagania, jeśli gra się w multi co-op, gdzie liczba wielokątów i efektów ogromnie rośnie. Minusem D3 niestety nadal do dzisiaj jest to, że gra mocno opiera się na mocy jednego rdzenia CPU - dzięki temu połączenia np. wysokotaktowanych i3 + kart NVidii będą się tam spisywać lepiej niż średniotaktowane i5 + AMD.

w wiekszosci spokojnych momentów ta gra jest bardzo mało wymagająca, ale jak już dochodzi do obliczeń fizyki (Havok) i zamieszania przy większych grupach (co będzie sie zdarzało bardzo często) to rosną tak wymagania od CPU jak i GPU. Jeszcze bardziej wzrastają wymagania, jeśli gra się w multi co-op, gdzie liczba wielokątów i efektów ogromnie rośnie. Minusem D3 niestety nadal do dzisiaj jest to, że gra mocno opiera się na mocy jednego rdzenia CPU - dzięki temu połączenia np. wysokotaktowanych i3 + kart NVidii będą się tam spisywać lepiej niż średniotaktowane i5 + AMD.-

1

1

-

-

640x480

Tyle miało Diablo II w momencie premiery 17 lat temu. I już wtedy narzekali w recenzjach, że to za mało!

Gra do dziś oferuje pełne cinematic experience ze swoim lockiem do 25 FPS.

-

GTX 970 najlepszym zakupem? I jeszcze w wersji Srix?

"Nie.", powiedział jego były właściciel.

Już wolałbym dopłacić trochę do GTX 980 (nie od Asusa) niż ponownie kupić tą kartę.

HD 6870 + World of Tanks 1080p + Max ustawienia jest bardziej ograniczany przez słabe możliwości CPU-FPS tego kiepskiego FX-a niż samą kartę, gdzie w trudnych momentach (28 FPS) jej wykorzystanie spada do 60%:

https://www.youtube.com/watch?v=iXxtKa5-jjk -

To zależy.

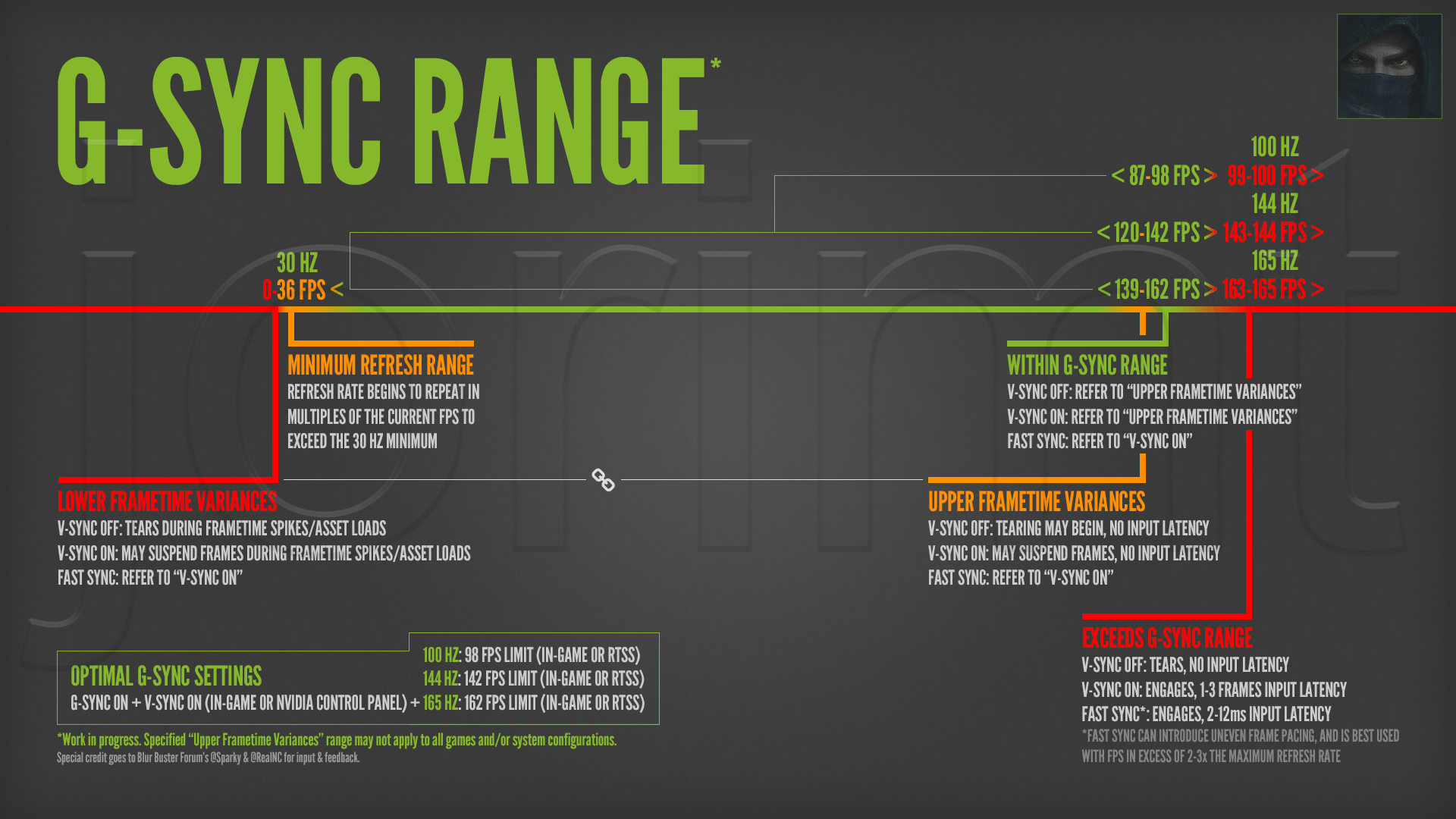

Poradnik odnośnie G-sync w jednym obrazku:

-

Zasilacz to pierwsza myśl. Musiałbyś sprawdzić tą kartę na zasilaczu conajmniej 600 W (conajmniej 42 Ampy na linii +12V), tak jak zaleca producent karty. Niewiem nawet co ci strzeliło do głowy, żeby do takiego zasilacza wstawiać kartę wymagającą minimum 600 W.

-

No to taki GTX 750 Ti 2 GB spokojnie powinien starczyć. Niedawno Proline miał promocję headshot na nową taką kartę za 299 zł.

-

1

1

-

-

Konsekwencje włączenia synchronizacji pionowej (V-sync):

- wyeliminowanie rwania obrazu (tearingu)

- ograniczenie max FPS do częstotliwości odświeżania monitora (Hz)

- zwiększenie input lag (czasu między użyciem myszy/klawiatury do pokazania efektu na ekranie)

- masywny stuttering jeśli karta nie potrafi utrzymać stałych Hz == FPS bez opóźnień

- jeśli FPS spadnie poniżej odświeżania Hz to ilość FPS z VSync == ilość Hz podzielona przez liczbę całkowitą (60,30,20,15 itd.)dwa ostatnie minusy można wyeliminować zamieniając V-sync na Adaptive V-sync (panel sterowania NVidii).

Poczytaj sobie o różnych technologiach synchronizacji pionowej i co to jest ograniczanie maksymalnego fps.

-

Podaj pełną specyfikację komputera, włącznie z modelem zasilacza i rozdzielczość monitora w której grasz. I określ budżet.

Nie wiadomo jak dzisiaj w D3 skaluje się wydajność na słabszych kartach z mniejszą ilością pamięci, bo w patchu 2.4.3 dodano obsługę DirectX11, Normal Maps i Per-Pixel Lightning, co znacznie powiększyło alokację pamięci na tekstury. Filmik który zalinkowałeś to jeszcze ta stara wersja D3D9 z niskimi wymaganiami od kart graficznych i praktycznie znikomym użyciem pamięci karty.-

1

1

-

-

Krótko, nie tłumacząc wszystkich zawiłości typu frametime, SLi scalingu, profili, przepustowości pamięci itd. - nie warto.

Lepiej mieć jedną mocną kartę (a zwłaszcza nowszą) niż dwie słabe. Do czego chciałeś ten drugi GTX zresztą?

-

Były MSI Gaming X GTX 1080 w okolicach 2070 zł, z cashbackiem. Sam kumplowi linkowałem.

-

Na stronie swojej płyty głównej masz zawsze podane wszystkie obsługiwane (z pudełka) procesory.

http://www.gigabyte.pl/products/page/mb/ga-m61pme-s2p_10/#support-cpu -

Tak wysokie taktowania to normalne przy GPU Boost NVidii. Jeśli karta nie przekracza ustalonego Power Limitu i temperatury są w normie, to następuje auto-overclocking w ramach ustalonych przez NVidię wartości.

Jedyne chyba co teraz możesz zrobić, to zmniejszyć zegary chipu i pamięci karty, i sprawdzić czy coś to zmienia w jej działaniu.

Jeśli to nie pomoże, to sprawdź kartę na innym komputerze. Jeśli i tam będą takie problemy - no to trzeba wysłać na gwarancję.-

1

1

-

-

Najpierw zainstalowałbym sterowniki na czysto przy pomocy DDU w trybie awaryjnym.

Jak nie pomoże to obniż taktowanie pamięci karty o np. -200 MHz w MSI Afterburner żeby sprawdzić jak to wpłynie na działanie karty.-

1

1

-

-

Wymiana wentylatorów raczej nie da ci za dużo, nie wiadomo nawet czy to możliwe, jak już to musiałbyś zmienić całe chłodzenie, bo to ono (jego efektywność w odprowadzaniu ciepła) jest problemem z głośnością karty. Karty, która ma dość wysokie zapotrzebowanie na energię i stąd mocno się grzeje, a skoro mocno się grzeje, to wentylatory rozkręcają się mocniej. Do tego zalecana też wymiana pasty termoprzewodzącej na np. Thermaltake Grizzly Kryonaut.

Poszukaj np. jakichś chłodzeń wodnych All-In-One kompatybilnych z danym modelem karty, jeśli twoja obudowa ma na nie miejsce.

Ceny GTX

w Karty graficzne

Napisano

NVidia niby planuje żywotność swoich kart Pascal na 5 lat, pod warunkiem że nie tyka się Power Limitu i nie bawi suwakiem napięcia.

Jak przesunie się suwak napięcia na 100% to żywotność skraca się już niby pięciokrotnie (do 1 roku).

Nie wiadomo jednak, jak wygląda procedura testowa, czy chodzi o rendering czy rendering i obliczenia, ale specjalne koparkowe wersje Pascali mają już gwarancję ograniczoną jedynie do 3 miesiecy. Już samo to powinno zapalić czerwone światełko.

Nie wiadomo też, jak bardzo jeszcze poprzedni właściciel żyłował taką kartę pod innymi względami, w jakiej temperaturze pracowała itd.

Zwyczajnie lepiej się nie pakować w coś takiego jeśli ktoś absolutnie nie musi i tyle.