-

Liczba zawartości

1855 -

Rejestracja

-

Ostatnia wizyta

Typ zawartości

Profile

Blogi

Forum

Kalendarz

Posty dodane przez ReznoR

- Poprzednia

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- Dalej

- Strona 2 z 75

-

-

QC jest w fazie bety i problemy z optymalizacją są olbrzymie. Chłopaki nawet z w tandemie i7 z 1080 ti nie mogą utrzymać stałych 120fps (ustawienia low). 8 GB ramu to za mało, 16 wskazane. Polecam co 3-4 mapy robić restart gry i launchera. Każdy tak robi, bo w innym wypadku zaczynają się olbrzymie dropy.

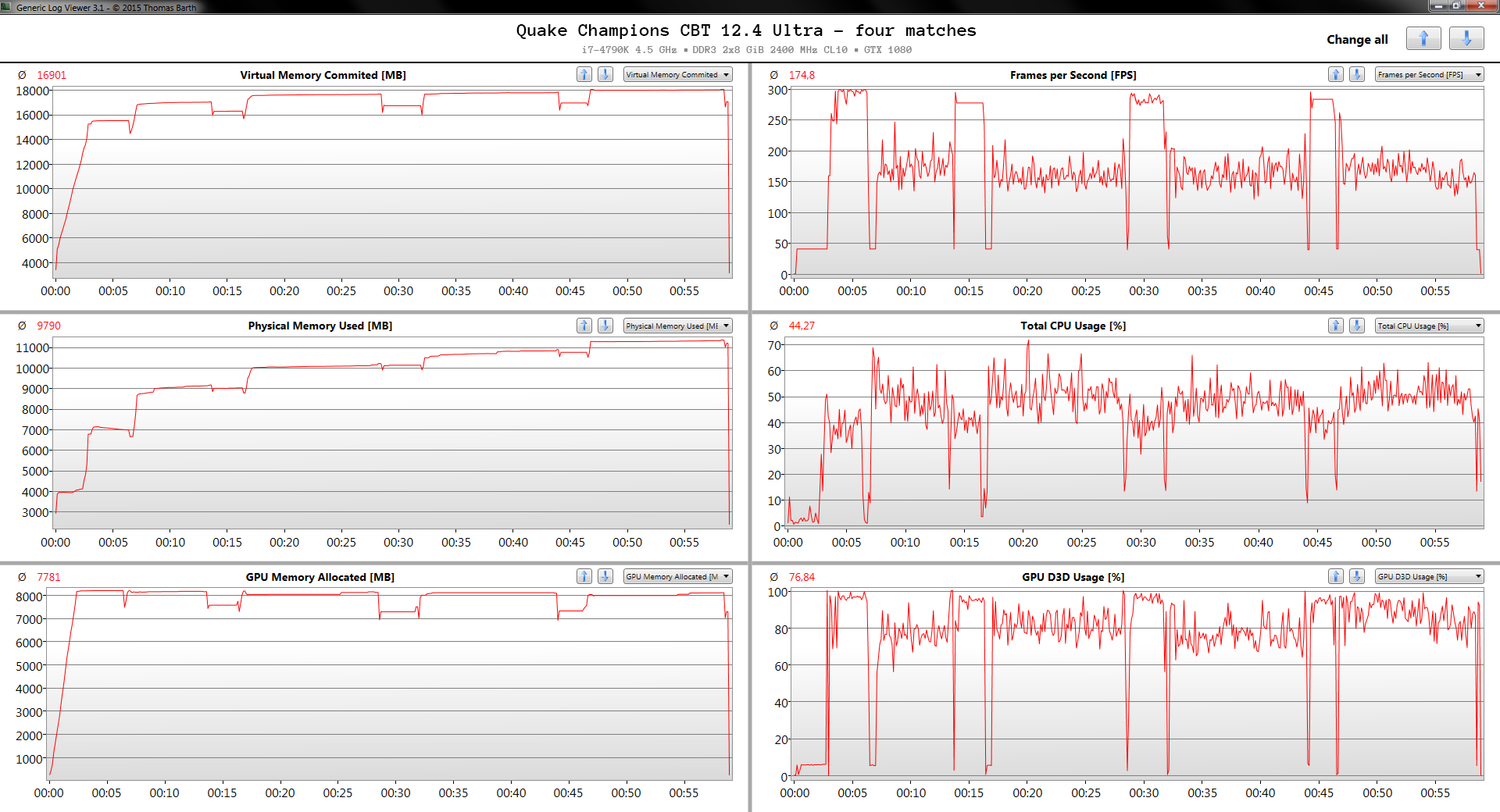

Wytrzymałem dzisiaj 4 matche w QC na Ultra. I u mnie to wygląda trochę inaczej.

Preset Ultra (!), 1920x1080, scaling 100%, fov 120

i7-4790K 4.5 GHz, DDR3 2x8 GiB 2400 MHz CL10, GTX 1080

Windows 7

Alokacja RAM (i/lub VRAM) rośnie z każdym rozegranym matchem, ale nie ma żadnych problemów z utrzymaniem powyżej 120 FPS. Minimalnie na wykresie widać ok. 125 FPS, a średni FPS w czasie rozgrywki oscyluje spokojnie powyżej 150. Jedyne co zauważyłem, to lekki stuttering na początku 4 matchu (nie zobaczy się tego na wykresie średniego FPS) ale szybko zniknął, więc to nic poważnego.

Jest gdzieś jakiś link do tematu z problemem z utrzymaniem wysokiego FPS na low na i7 i 1080 Ti? Bo jestem ciekaw dlaczego u mnie na 4 generacji CPU, 3 generacji DDR, GTX 1080 i "przedpotopowym" Win7 nie udaje się tych olbrzymich dropów osiągnąć nawet na Ultra.

Być może 4 matche to za mało - ale przykro mi, więcej nie dałem rady wytrzymać.

Być może 4 matche to za mało - ale przykro mi, więcej nie dałem rady wytrzymać.-

1

1

-

-

BIOS do karty czy do płyty głównej?

-

Odeślij na gwarancję/rękojmię, może dostaniesz nowy model. Nie wiadomo co poprzedni własciciel z tą kartą robił w końcu, ale jeśli jest możliwość skorzystania z gwarancji/rękojmi do pierwszego roku od kupna, to lepiej skorzystać, niż liczyć na to, że kiedyś się poprawi (bo się nie poprawi). Do 1 roku od kupna konsument ma wyższe prawa.

No chyba, że to jeszcze wina sterowników czy czegoś innego (np. zasilacza czy OC procesora). Nie wygląda na to, ale różnie może być.

Możesz zrobić czysty uninstall sterowników przy pomocy Display Driver Uninstaller w trybie awaryjnym dla pewności i "odkręcić" procesor żeby sprawdzić czy to wina tego. -

Dziwne, u mnie bez problemu mam powyżej 120 fps na Ultra, choć ostatnio nie sprawdzałem jak to wygląda po 3-4 grach, bo predzej mnie ta gra wkurzyla niz dotarłem tak daleko.

Long story short: oczywiście że wpływa, bo to nie jest 4 GiB, tylko 3,5 na 224 bit szynie + reszta cache, a nie pełny, normalny design. Gdyby nie wpływało to nie kupowałbym GTX 1080 a ludzie nie pisaliby wszędzie, że mają masę dziwnych problemów, włącznie ze mną.4. Wyniki GTX 970 w ustawieniach Very High są zaskakujące, ale były powtarzane kilkukrotnie na dwóch samplach i zawsze wychodziły identyczne. Pierwszy przelot miał wyższy FPS, ale kolejne już notowały ogromne spadki. Wyjaśnienia widzę dwa - wina samej gry albo podsystemu pamięci GTX 970. RotTR w pierwszym przelocie ładuje tekstury ~3600 MB. potem wartość ta systematycznie rośnie do ~4050 MB i zaczynają się problemy. Inne karty graficzne takich problemów nie miały - wyniki były powtarzalne od początku do końca.

Możliwe oczywiście, że od tamtego czasu zablokowali co nieco w sterownikach, żeby zminimalizować problemy, ale nie zmienia to faktu, że ta karta ma faktycznie 3,5 GiB pamięci "szybkiego FPS", a nie 4 GiB jak GTX 980.

W "Rise of Tomb Rider" musiałem obniżyć tekstury i miałem mniejsze zużycie ramu.

Gdy karcie brakuje pamięci VRAM, to reszta danych potrzebna karcie jest alokowana w pamięci RAM.

-

Problemy w twoim przypadku ograniczające ci maksymalne możliwości karty graficznej w grach to:

- Wolny procesor

- Wolna pamięć (DDR2)

- Mało pamięci

Jeśli zamierzasz dodać pamięci to radzę szukać albo dokładnie takich samych jakie masz (2x2 GiB i najlepiej ten sam model) albo sprzedać te co masz i szukać 2x4 GiB, żeby uniknąć ewentualnych problemów kompatybilności. No i koniecznie muszą pracować w Dual Channel - bo nie będziemy przecież jeszcze bardziej obniżać ich wydajności konfiguracją Single Channel.

Ale tak szczerze, to inwestycja w tą starą platformę jest raczej kiepskim pomysłem - z tym procesorem i DDR2 za wiele nie zdziałasz w grach. To właśnie m.in. niska wydajność Phenomów w grach była moją motywacją do zmiany platformy, tak jak i dla wielu innych ludzi.

Pamiętaj też, żeby mieć na uwadze małą pamięć tej karty - 2 GiB w dzisiejszych grach wymaga często redukcji jakości Tekstur aby zachować optymalne możliwości karty. Jak przesadzisz z optymalnym ustawieniem tekstur, to będziesz miał różne dziwne problemy, ze zmniejszeniem FPS włącznie.-

1

1

-

Czyżby "mało używana karta" po pracy w kopalni?

-

1

1

-

-

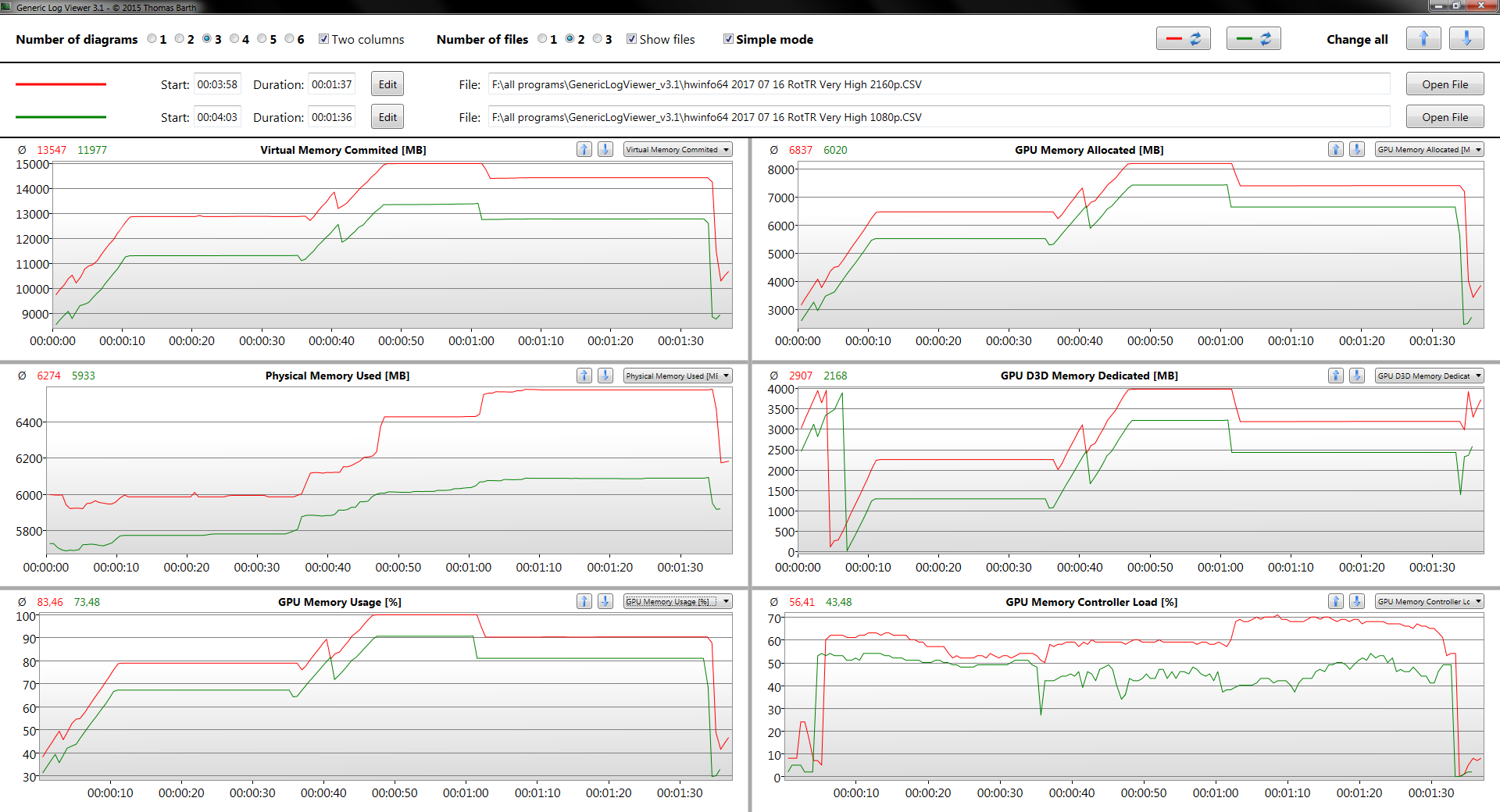

RotTR benchmark, przejście nr 3, porównanie 1080p vs 2160p:

Direct3D11, Windows 7, GTX 1080, preset wbudowany Very High, AA off.

Przy 2160p nawet GTX 1080 jest zapchany na full przy Direct3D11, gdzie wykorzystanie pamięci jest mniejsze niż na Direct3D12.

Przy 2 GiB+ przekroczonej alokacji pamięci trudno oczekiwać, że gra będzie działać bezproblemowo, zwłaszcza w 2160p, gdzie ilość pikseli do wyrenderowania wzrasta 4-krotnie.

Jak to wygląda w przypadku Direct3D12 nie pokażę na wykresie, bo Win10 jeszcze przez długi czas u mnie nie zawita (jeśli w ogóle), zresztą nie mam karty z wystarczająco dużą ilością pamięci, żeby pokazać całość alokacji (możnaby jedynie interpolować poprzez dodanie różnicy w Virtual Memory Commited, choć nie jest to ani dobre ani dokładne rozwiązanie)

Ale ogólnie alokacja pamięci i jej wykorzystanie przez kartę w przypadku Direct3D12 zawsze wzrośnie względem Direct3D11, bo tak to już jest z programowaniem na tym API. -

Dziwne, ale Fury X ma znacznie wyższą alokację niż GTX 980 Ti na tym video, i w momentach w których występuje stuttering nie widać, żeby alokacja była przekroczona. Nie wiadomo też, jak było nagrywane video. Nie sądzę, żeby sama alokacja pamięci miała znaczenie w tym przypadku, problem raczej siedzi gdzieś indziej.

4K w Very High w RotTR przy 6 GiB VRAM? Zwariowałeś?

To się w ogóle nie dziwię, że miałeś taki stuttering.

To się w ogóle nie dziwię, że miałeś taki stuttering. -

Tak, jednakże szybsza przepustowość (zmniejszanie rozmiaru tego, co karta musi renderować dla każdej klatki) to szybsza wydajność przy tej samej ilości pamięci, szybkości pamięci i tej samej szerokości szyny, i właśnie o to chodzi.

Niemniej jeśli granica odpowiedniej ilości VRAM zostanie przekroczona, to wtedy nie ma bata - obojetnie jak szybka przepustowość by nie była, wydajność itak spadnie! Kwestia nie "czy" tylko "o ile".

Tutaj przykład jak przekraczanie granicy optymalnej ilości pamięci VRAM wpływa na różnice w wynikach FPS:- kart 4 i 8 GB (RX 480 - 54% różnicy)

- kart 3 i 6 GB (GTX 1060 - 206% różnicy)

- kart 2 i 4 GB (GTX 960 - 140% różnicy)

Drastyczny przypadek, owszem (bazuje na jednej z "trudniejszych" opcji w RE), ale służy tylko do demonstracji zasady.

R9 390 8 GiB znacznie szybsze niż Fury X.To też zresztą też jedna z przyczyn, dlaczego stare karty NVidii tak słabo sobie radzą w nowych testach na nowszych grach w porównaniu z Radeonami, które przeważnie tej pamięci miały więcej w tej samej półce cenowej. Wykorzystanie pamięci w nowych grach rośnie coraz szybciej.

-

Radeony i Keplery mają trochę gorzej. Nie można bezpośrednio porównywać różnych architektur, czy to NVidia czy AMD, ze względu na różne technologie kompresji pamięci - np. Maxwelle i Pascale mają znacznie wyższą jej efektywną przepustowość ze względu na mocniejszą kompresję.

Przy Polarisach trochę się AMD poprawiło dopiero pod tym względem.

http://images.anandtech.com/graphs/graph10325/82902.png

http://www.anandtech.com/show/10325/the-nvidia-geforce-gtx-1080-and-1070-founders-edition-review/8Pozatym RotTR zawsze było szybsze na kartach GeForce - jeśli R9 390 8 GiB jest 44% szybszy niż GTX 970 3,5 GiB na Very High, to już samo to mówi, że przyczyna leży w zbyt niskim VRAM GTX 970, aby mógł utrzymać efektywną wydajność na poziomie możliwości swojego chipu. No i druga sprawa, to j.w. - jakby VRAM nie był winny, to różnice między 970 a 980 i GTX 1060 3 vs 6 GiB nie byłyby tak wielkie.

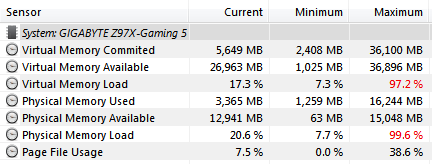

Jeśli wydajność spadnie ze względu na braki w VRAM, to wtedy również na wskaźniku będzie widoczne wykorzystanie karty na poziomie 99-100%, więc trudno to odróżnić bez testów porównawczych.

Najprościej sobie zrobić pomiar porównawczy. Jeśli wydajność dość mocno wzrosła po zmniejszeniu jedynie parametru Texture Quality, to już oznaka, że na wyższy preset brakuje karcie pamięci, aby utrzymać FPS na poziomie efektywnych możliwości karty.

Posiadacze GTX 1060 3 GiB nie ustawiają presetu tekstur Very High w RotTR, ze względu na masywny drop FPS, o co sam spytałem np. w komentarzu do tego filmu:

https://www.youtube.com/watch?v=mjauw5NlVwE

-

Każda karta zacznie progresywnie spowalniać, im bardziej alokacja VRAM zostanie przekroczona - kwestia tylko tego, kiedy zacznie być to zauważalny spadek i jak bardzo w danym momencie gra opiera się na wykorzystaniu pamięci, aby wyrenderować obraz, bo to się dynamicznie zmienia w każdej scenie. Presety w grach przeważnie optymalizowane są przez developerów do zaokrąglonych wartości pamięci kart np. 2 GiB, 3 GiB, 4 GiB, stąd też jeden z problemów GTX 970.

Np. Rise of the Tomb Raider w wymaganiach zalecanych ma podanego GTX 970 przy ustawieniach wysokich - przy tych ustawieniach gra alokuje ok 3,5 GiB pamięci, co jest wystarczające w zupełności nawet dla kart 3 GiB (takich jak GTX 1060 3 GiB) bo nie wpływa to aż tak mocno na wydajność, żeby brać to pod uwagę. Natomiast ustawienie presetu Very High alokuje już od 4 GiB w górę, co dla GTX 970 przestaje być na tyle optymalne, aby utrzymać sensowny FPS i frametime, za to bez problemu można na tym ustawieniu grać na kartach 4 GiB, np. GTX 980, i nie będzie żadnych widocznych problemów.

Tutaj preset tekstur Very High (dla kart 4 GiB i w górę - przy tym presecie GTX 1060 3 GiB i GTX 970 mają problemy z utrzymaniem wysokiego FPS, a GTX 980 i Fury nie mają żadnych problemów):

Ogólnie wszystko rozchodzi się o dobrą optymalizację wykorzystania pamięci karty, a QC niestety ma z tym problem od zawsze, i problemów nadal nie widać końca, a do czasu ich rozwiązania trzeba kombinować. -

Sprawdziłem właśnie Quake Champions na Texture Quality Medium i jest tak jak myślałem. Już w czasie pierwszego meczu alokacja pamięci VRam skoczyła do prawie 5 GiB. Jakbym grał parę innych to pewnie byłaby jeszcze wyższa. Także proponuję zmniejszyć Texture Quality do Low, powinno być lepiej. No chyba że preset Low też spieprzyli w nowych patchach. Kiedyś jak sprawdzałem, to preset Medium alokował ok 3,5 GiB a Low ok 2,5 GiB.

-

Ten filmik jest stary. Oni co chwilę coś zmieniają w tej grze. Jest mnóstwo bugów. Na reddicie jeden gość z GTX 1080 Ti 11 GiB nie mógł ustawić Texture Quality Very High, bo gra mu nie pozwalała (ten sam błąd), mimo że ja na swoim GTX 1080 potrafiłem bez problemu odpalić na 7680x4320 na Very High + 200% skalowanie. W samym menu miałem 36 GiB wykorzystania pamięci wirtualnej, mimo posiadania jedynie 16 GiB RAM + 8 GiB VRAM. Kwestia odpowiednich ustawień pamięci wirtualnej w systemie I guess (najlepiej ustawić sobie nielimitowaną).

Na czym polegają te lagi, możesz to opisać dokładniej, albo nagrać coś, czy zrobić jakiś benchmark?

Znając tendencję bety Quake Champions i powiekszanie wykorzystania pamięci oraz dziwne zachowanie podsystemu pamięci GTX 970 to mozesz jeszcze sprawdzić czy jak zmienisz Texture Quality na Low to czy lagi znikną.

No i upewnij się że skalowanie masz ustawione nie więcej niż na 100%.

Inna przyczyna lagów jaka może być to np. posiadanie tylko jednej kości pamięci lub praca kości w Single Channel zamiast w Dual Channel. -

Quake Champions to znany pożeracz RAMu i VRAMu na ustawieniach Texture Quality High i Very High.

Przy twoich 8 GiB i 3,5 GiB na GTXie 970 radziłbym ci unikać tych dwóch presetów tekstur.

Przestaw na Texture Quality == Medium i zaraz powinno być lepiej.

W dodatku w jednych z ostatnich wersji bety znowu powiększyło się wykorzystanie pamięci w porównaniu do tego co było kiedyś. Podejrzewam że w przyszłości będą optymalizowali wykorzystanie pamięci.

-

Czasami tak właśnie jest z pamięciami. Różnie wygląda sprawa kompatybilności, i czasami obojetnie czego byś nie zrobił, to nie zadziałają razem. Dlatego radzi się zawsze kupować dwa identyczne modele kości i najlepiej nie mieszać ich z kościami innych producentów czy nawet innych modeli.

-

Dzięki za info!

-

1

1

-

-

A ja leżę i kwiczę jak widze odpowiedzi tego typu. Skąd macie Panowie taką wiedzę? Czemu nie CF z tańszych kart, hm? Ja odpowiem obiektywnie bo Wy zamiast odpowiedzieć krytykujecie.

http://pclab.pl/art52456-16.html

Sekcja "GTX Titan kontra karty graficzne z dwoma rdzeniami".

To są ponadczasowe informacje, ważne do dziś - po polsku. Tylko kilka z nich niestety, nie ma np. kwestii temperatur czy linii PCI-E oraz tym jak działa alokacja pamięci w takich układach.

Ponadto Crossfire i SLi dzisiaj zwyczajnie powoli umiera śmiercią naturalną, właśnie ze względu na masę problemów z tym związanych. Ani nie lubią tego producenci układów graficznych, ani programiści gier. Również np. NVidia, nie bez powodu, wyłącza obsługę SLi w swoich kartach GTX 1060 i poniżej.

Dla angielskojęzycznych polecam też lektury zagadnienia frametime'u:

- Inside the second: A new look at game benchmarking

- Where minimum-FPS figures mislead, frame-time analysis shines

Djxbeat z forum może wam też opowiedzieć swoją historię o doświadczeniach z Crossfire z RX 480, jak go zapytacie.

Ponadto, nowe API graficzne - D3D12 i Vulkan - jeszcze bardziej utrudniają przygotowywanie gier pod konfiguracje multi-GPU. Programiści tak sterowników jak i gier dosłownie przeklinają prace nad konfiguracjami multi-GPU. Te technologie naprawdę nie mają przyszłości i powoli, ale skutecznie coraz bardziej się od nich odchodzi - a przynajmniej w grach.

Ostatnią kartą multi-GPU NVidii była GTX Titan Z (2014), a AMD - Radeon Pro Duo (2016).

Obie karty były bardziej przeznaczone na rynek obliczeniowy niż do grania.

Szczerze wątpię, żebyśmy zobaczyli jeszcze karty multi-GPU przeznaczone do grania.

-

1

1

-

No to jedynie aktywny konwerter, najlepiej DisplayPort -> D-sub, gdyż nie ma szans "przesyłania" obrazu z jednej karty do drugiej.

Na LAN do gier wymagających szybkiej reakcji może to nie być zbyt dobry pomysł, bo może wprowadzać zauważalne opóźnienia (input lag).

Używanie monitorów LCD ze złączami D-sub jest bardzo nieefektywne, bo wymaga to aż dwóch konwersji sygnałów - przy wyjściu z karty (cyfrowy->analog) i w monitorze (analog->cyfrowy).

Monitory LCD są natywnie cyfrowe, w odróżnieniu od starych kineskopów, które zwyczajnie sygnału analogowego wymagały. Brak wejścia cyfrowego w monitorze LCD to oznaka cięcia kosztów. -

Najmniejszy możliwy koszt, w przypadku gdy chcesz ten monitor jako dodatkowy do pracy (GTX 1050 Ti okupowałby twój główny monitor) to podłączenie tego monitora bezpośrednio do IGP w procesorze, pod warunkiem że na płycie masz D-sub (ew. można użyć tam adaptera DVI->D-sub).Zapomniałem, że nowe IGP nie obsługują sygnału D-sub.

Chodzi mi o to, że mój 1050Ti renderuje swoje, po czym wysyła sygnał do starszej karty, a ta do monitora.

A dlaczego tak? To ma być twój jedyny monitor?

-

Jeśli jest możliwość brania GTX 1050 2 GiB w cenie tego RX 560 2 GiB to lepiej poprostu wziąć GTX.

RX 560 czy GTX 1050 to znacznie lepsze wybory niż RX 550 czy GT 1030, pod kątem tak wydajności jak i opłacalności, bo od RX 550 szybszy jest już nawet stary GTX 750 Ti (który przypominam - niedawno był w promocji za 299 zł)Pod kątem ogólnej hierarchi wydajności wygląda to mniej wiecej tak (w zależności od różnych gier, ustawień i miejsc testowych będzie się to różnić oczywiście):

- GTX 1050

- RX 560

- RX 460

- GTX 750 Ti

- GT 1030 = RX 550

-

1

1

-

A skanowałeś sobie wszystkie dyski jakimś antywirusem? Szczerze wątpię, żeby to wina jakiegoś wirusa była.

No i j.w. kolega mówi, ten informatyk raczej ci nie pomoże skoro tak pisze o sterownikach.

Jeśli kilka formatów z rzędu nie pomaga, a mówisz, że częstotliwość błędów zmienia się wraz ze zmianą obciążenia karty, to chyba można podejrzewać że to jednak ten zasilacz, bo to ostatnia opcja.-

1

1

-

-

Pierwszy publiczny pokaz RX Vega w akcji będzie miał miejsce 18 lipca na Węgrzech:

https://radeon.com/en-us/rx-community-meetup/?sf97206526=1 -

Ja tylko mówię, że trzeba mieć to wszystko na uwadze przed kupnem. To co ktoś z tym zrobi, to już jego sprawa przecież, jego pieniądze. Ja nigdy z czystym sumieniem nie poleciłbym kupowania nikomu takich kart przed właściwym ostrzeżeniem odnośnie potencjalnego niebezpieczeństwa na które się naraża. Wiadomo że znajdzie się niestety mnóstwo chętnych na "mało używane" karty i nic się z tym nie zrobi. Ale ostrzegać trzeba, a nie zachęcać.

-

1

1

-

-

Te procesory kosztują grosze:

http://allegro.pl/procesor-intel-xeon-5150-2-66ghz-4m-1333-i6675293430.html

A jak samemu zrobić to satysfakcja znacznie większa.

Tylko od razu mówię, że lepiej nakleić kawałek bezbarwnego laminatu na wierzch IHS - zabezpieczy to przed zarysowaniem i starciem oznaczeń.

Ja do swojego dostałem nawet pastę termoprzewodzącą gratis... Nikt tego już nie chce jako sprzętu komputerowego, a brelok posłuży dłuuugo.

Nikt tego już nie chce jako sprzętu komputerowego, a brelok posłuży dłuuugo.

- Poprzednia

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- Dalej

- Strona 2 z 75

Uszkodzona karta graficzna

w Karty graficzne

Napisano · Edytowane przez ReznoR

GTX 950 miał premierę w 2015 r. Mamy 2017. Asus daje 3 lata gwarancji. Powinieneś mieć conajmniej 1 rok gwarancji jeszcze.

Dla pewności zrób ten sam test 1650 MiB u kolegi i będziesz wiedział.